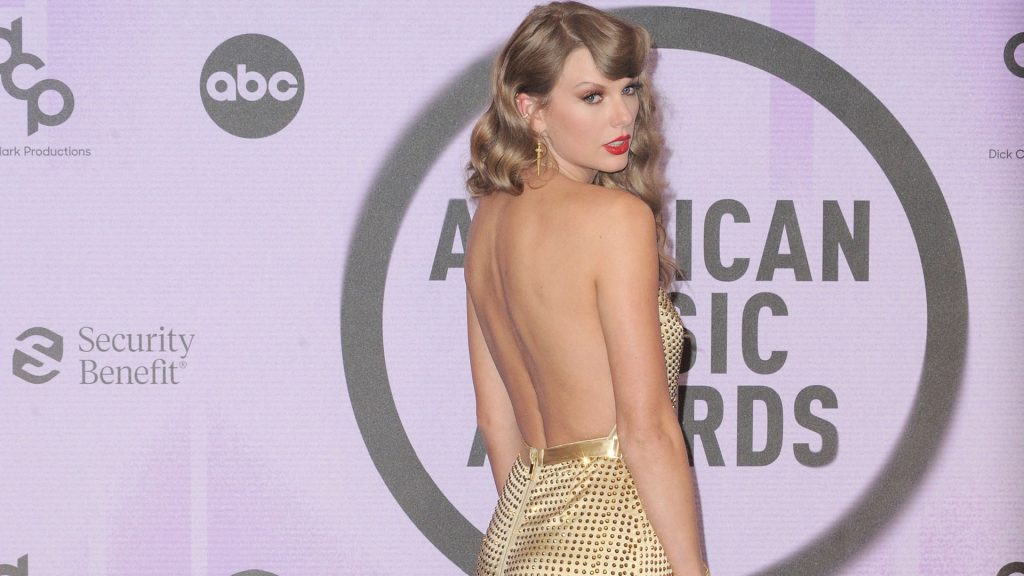

Durante unos días, varios deepfakes con imágenes explícitas manipuladas de Taylor Swift empezaron a difundirse en redes sociales; todos, contenidos pornográficos (también de carácter violento) generados con Inteligencia Artificial (IA) sin el consentimiento de la artista. La mayoría se publicaron en X (la antigua Twitter), que decidió bloquear las búsquedas relacionadas con la cantante como medida de protección, según Associated Press.

Su equipo de Seguridad también dijo en un post que estaban “eliminando activamente todas las imágenes identificadas y tomando medidas contra las cuentas responsables de las publicaciones”. Pero estas decisiones se tomaron cuando los contenidos ya habían llegado a “millones de usuarios”, critican organizaciones especializadas en detectar IAs como Reality Defenders.

¿Son suficientes, entonces, las políticas de contenidos de las plataformas para proteger a los usuarios? ¿Cómo regulan los gobiernos la difusión de deepfakes sin autorización? Hablamos con expertas para analizarlo.

El tiempo de reacción de X, clave en la difusión de deepfakes como los de Taylor Swift hechos con IA

Muchas plataformas tienen sus propias políticas para controlar la difusión de contenidos sexuales hechos con IA y no consentidos. En su caso, las normas de la comunidad de X prohíben expresamente compartir imágenes o vídeos de esas características, también cuando se esté “manipulando digitalmente la cara de alguien” para acoplarla “al cuerpo desnudo de otra persona” (lo que incluye el caso de los deepfakes de Taylor Swift).

Pero con las imágenes de Taylor Swift, las especialistas consultadas por Newtral.es advierten de que la plataforma tardó en reaccionar, y fue un tiempo clave para su difusión. Esto a pesar de los esfuerzos de los swifties, que iniciaron una campaña para compartir contenido positivo de la cantante y compensar, así, la propagación de imágenes ilícitas.

Así lo señala Silvia Martínez, profesora de Ciencias de la Información y de la Comunicación de la Universitat Oberta de Catalunya (UOC): “Lo más desconcertante es el tiempo de reacción y de respuesta de la plataforma, aquí es donde se ven las flaquezas a la hora de tomar medidas, sobre todo teniendo en cuenta el nivel de impacto y de viralización de un personaje tan conocido”.

Un apunte. Uno de estos posts se llegó a eliminar 17 horas después de haberse publicado, según el digital especializado The Verge. Durante ese tiempo, consiguió más de 45 millones de visualizaciones y 24.000 reposts en la plataforma.

Las medidas tomadas por X, “eficaces”, pero sus políticas, “insuficientes”, según los expertos

Sobre las medidas adoptadas por X, Martínez cree que “limitar los términos de búsqueda puede ser eficaz para que no te llegue ese contenido [como usuario], aunque lo podemos recibir de otra manera”, como a través de enlaces directos. De hecho, “rastrear todo ese contenido sería muy exhaustivo, aunque estas plataformas ya tienen sus protocolos contra la desinformación y podrían hacer un seguimiento más en detalle de todos estos fake”.

En esa línea, Selva Orejón, experta en ciberseguridad y fundadora de la consultora onBRANDING, cree que “es muy positivo que se limite la difusión de deepfakes, pero las plataformas deberían de hacer mucho más para proteger a sus usuarios”. Añade que “las políticas actuales son insuficientes y se necesita una revisión constante, teniendo en cuenta, por ejemplo, que sigue habiendo social ads (anuncios en redes) que usan imágenes, logos y voces de personajes públicos o medios de comunicación [sin su consentimiento]”. Le pasó también a Taylor Swift hace poco: a principios de enero, se viralizaron una serie de vídeos en los que se emulaba su voz con una IA para que pareciese que ofrecía baterías de cocina gratis de una conocida marca francesa, como verificaron en AFP y el New York Times.

Para Sonia Herrera, especialista en estudios feministas y también profesora de Ciencias de la Información en la UOC, aún queda mucho por hacer en ese sentido: «Todavía estamos muy en pañales. La autorregulación de las empresas de IA y de las plataformas sigue teniendo muchas lagunas, intereses e ideología. Siguen sin ponerse filtro, por ejemplo, a muchos mensajes de odio, a pesar de que se denuncian. No podemos ser naif a la hora de ver quién está detrás de estas herramientas».

Los otros condicionantes de X: el factor Elon Musk

También hay otros condicionantes que hacen de X una red social más laxa a la hora de limitar determinados vídeos o imágenes explícitos, según las especialistas. “A diferencia de otras plataformas, no tiene una sensibilidad tan extrema con estos contenidos y no cuenta con protocolos automatizados que permitan eliminarlos directamente cuando, por ejemplo, se ven determinadas partes del cuerpo, etc”, señala Silvia Martínez.

Además de todo esto, está el factor Elon: “Musk intentó reivindicar Twitter como un espacio de libertad para expresarse y, aunque el control previo es prácticamente imposible (implicaría, incluso, no saber qué se está filtrando), no quita que haya contenidos que puedan infringir determinados marcos legislativos”, comenta la investigadora de la UOC.

La compra de la plataforma por parte del magnate y los cambios que introdujo cambiaron totalmente la experiencia en X. De hecho, una de las decisiones que marcó su año al frente de la app fue el despido de miles de trabajadores, incluidos equipos de moderación encargados de revisar contenidos dañinos, como los que esta semana ha retirado de Taylor Swift.

El papel de otras plataformas: el caso de TikTok, Instagram o Telegram

¿Y qué hacen otras apps con estos contenidos? Instagram, por ejemplo, elimina directamente los que infrinjan las normas de su comunidad cuando se estén publicando desnudos (eso incluye actos sexuales, por ejemplo, o fotos de pezones de mujeres, lo que reafirma los estereotipos que se siguen proyectando sobre ellas, como advierten las expertas).

Lo que hace Meta (la matriz de Instagram), es automatizar gran parte del proceso, creando modelos de IA con los que detectan si una imagen contiene desnudos, aunque hay una parte del contenido que también se revisa de forma manual.

TikTok tiene un sistema parecido para evitar que se cuelen contenidos como los generados por IA de Taylor Swift. La plataforma también los revisa de manera automática, pero cuenta con unos 40.000 moderadores en todo el mundo para chequearlos manualmente.

La app asegura que sus normas de la comunidad “obligan” a identificar claramente el contenido generado por IA que muestre “escenas realistas”, como los deepfakes, pero, en realidad, esta posibilidad es solo opcional para los usuarios a la hora de subir un vídeo (la app te deja hacerlo, pero puedes publicarlo sin marcar esa opción). En la práctica, este contenido se acaba extendiendo sin ningún tipo de etiqueta que lo identifique en muchos casos.

Las redes privadas. Más difícil es hacer ese trabajo de rastreo en aplicaciones más cerradas. Algunas de las imágenes de Taylor Swift generadas con IA se empezaron a publicar en 4chan (un foro del que han salido teorías como la conspiración de QAnon) y en “un grupo específico de Telegram” centrado en compartir imágenes, no consentidas, de mujeres con carácter sexual, según una investigación del portal tecnológico 404 Media.

Una de las herramientas que utiliza habitualmente este grupo para generar imágenes con IA es un conversor de texto a imagen desarrollado por Microsoft, según 404 Media. Satya Nadella, el CEO de esta compañía, cree que la situación, en el caso de Swift, es “alarmante y terrible”. “Tenemos que actuar (…) todos saldríamos beneficiados si el mundo online fuese un espacio seguro”, apremiaba en una entrevista reciente en la NBC.

Para Selva Orejón, “a la vista está que la naturaleza cerrada de Telegram, y dónde está ubicada tanto la plataforma como sus servidores, dificultan la tarea de identificar el origen y cortar la difusión de los deepfakes; si colaborase más, sería diferente”.

El trasfondo de las imágenes de Taylor Swift hechas con IA: una forma de violencia que afecta sobre todo a mujeres

No es casualidad que el grupo de Telegram que originó los deepfakes de Taylor Swift comparta habitualmente contenido misógino. Son las mujeres las que sufren este tipo de violencia más a menudo, como señala, entre otras, la organización Women in International Security. Y los efectos que genera en ellas van desde la pérdida de autoestima al ostracismo en lo que se refiere a su “vida online” como estrategia para protegerse, como explican en el informe Adult online hate, harassment and abuse: a rapid evidence assessment de la University of East London y la London School of Economics.

«No deja de ser un ataque a la intimidad de las mujeres, una vuelta de tuerca más a la difamación de siempre. Además, siempre habrá una parte de la población a la que no le llegará el desmentido, por eso se hace más difícil desmontarlo», explica Sonia Herrera.

- “El patriarcado es un sistema que penaliza la libertad sexual de las mujeres y, cuando queda expuesta, aunque sea con imágenes falsas, la sensación de desprotección, violencia y pérdida de control es real”, explica también la investigadora Cristina Pujol en un artículo de la UOC.

Además, cada vez es más común que ocurra esto (pasó recientemente en España, por ejemplo, con el caso de varias adolescentes de Almendralejo) porque muchas de las herramientas con las que se generan estos contenidos ya son gratuitas y de fácil acceso. Y eso hace que se creen más. Está cuantificado: en un estudio reciente, la revista WIRED contabilizó, junto a un “investigador independiente”, el número de deepfakes pornográficos en 35 de las principales webs que almacenan estos vídeos de varios países; solo en 2023, calcularon que había aumentado un 54% con respecto a 2022.

La legislación del contenido generado por IA como los deepfakes de Taylor Swift

Desde hace un tiempo, también se debate sobre la posibilidad de que sean los propios gobiernos los que regulen estos contenidos (la UE acaba de aprobar, por ejemplo, su propia ley integral de IA, que establece determinados límites al uso de esta tecnología).

En el caso de Estados Unidos, “no hay una ley federal específica sobre deepfakes”, explican en el New York Times, pero, a raíz del caso de Taylor Swift, algunos congresistas (e incluso la Casa Blanca), ya han pedido que se endurezca la normativa sobre este tipo de contenidos o incluso han tratado de promover la aprobación de nuevas leyes.

En España, tampoco hay una regulación concreta, aunque en octubre del año pasado, Sumar, por ejemplo, presentó una proposición de ley para “regular las simulaciones de imágenes y voces de personas generadas por IA”. En su primer artículo incluía como infracción grave la difusión de estos contenidos sin consentimiento.

En ese sentido, Herrera cree que «las instituciones sí suelen responder en la medida de lo posible, pero todo lo que tiene que ver con la IA va más rápido que la capacidad que tenemos de legislar y poner cotos. Mi sensación es que nos pilla siempre a contrapié. Cuando conseguimos identificar una nueva tecnología usada de forma fraudulenta, una nueva violencia en el marco de las redes, ya está apareciendo otra nueva».

La falta de una educación «transversal» en igualdad

Pero más allá de la intervención de los gobiernos, Martínez, Orejón y Herrera coinciden en la importancia de la educación mediática y en igualdad para concienciar sobre el mal uso de este tipo de tecnologías.

«El desmantelamiento del patriarcado y de los discursos misóginos pasa por hacer mucha pedagogía desde edades muy tempranas. Estamos en un momento muy reaccionario y falta mucha educación en valores que contemple cuestiones como la diversidad de género, la perspectiva racializada, los feminismos, etc», explica Sonia Herrera.

En casos como el de las imágenes de Taylor Swift hechas con IA se percibe mucho más: «Cuando hablamos, por ejemplo, de consentimiento, no solo hablamos de temas físicos que tienen que ver con las relaciones sexuales, es mucho más. El ciberacoso o las venganzas pornográficas son algunas de esas lagunas que demuestran que no hay una formación transversal en igualdad; todavía dependemos, a nivel educativo, de la buena voluntad de los cuerpos docentes y de la implicación que tengan», añade la profesora.

Aunque no está todo perdido y también «conviene poner el foco en lo positivo», aclara Herrera, porque las nuevas generaciones «tienen hoy mucha más conciencia feminista que hace años» y eso puede ser clave para que haya un cambio real.

(*) El artículo se ha actualizado para añadir más información y algunas declaraciones de expertas

(**) Nota aclaratoria: Newtral forma parte del programa global de verificación de datos y lucha contra la desinformación de Meta y TikTok.

- Sonia Herrera, especialista en estudios feministas y profesora de Ciencias de la Información en la UOC

- Silvia Martínez, profesora de Ciencias de la Información y de la Comunicación de la Universitat Oberta de Catalunya (UOC)

- Selva Orejón, experta en ciberseguridad y fundadora de la consultora onBRANDING

- ‘X pauses some Taylor Swift searches as deepfake explicit images spread’ (Associated Press, 29/01/2024)

- ‘Deepfake explicit images of Taylor Swift spread on social media. Her fans are fighting back’ (Associated Press, 27/01/2024)

- Post del equipo de Seguridad de X sobre sus políticas de Posting Non-Consensual Nudity (26/01/2024)

- Normas de la comunidad de X (políticas sobre el contenido secual no consentido)

- ‘Trolls have flooded X with graphic Taylor Swift AI fakes’ (The Verge, 25/01/2024)

- ‘Taylor Swift video altered in bogus Le Creuset giveaway ads’ (AFP, 11/01/2024)

- ‘No, That’s Not Taylor Swift Peddling Le Creuset Cookware’ (The New York Times, 9/01/2024)

- Normas comunitarias de Instagram

- ‘Cómo utiliza Instagram la inteligencia artificial para moderar el contenido’ (Servicio de ayuda de Instagram)

- Información corporativa de TikTok sobre el contenido generado por IA en la plataforma

- ‘AI-Generated Taylor Swift Porn Went Viral on Twitter. Here’s How It Got There’ (investigación del portal tecnológico 404 Media)

- Entrevista al CEO de Microsoft, Satya Nadella, en la NBC

- ‘Deepfakes as a Security Issue: Why Gender Matters’ (análisis de la organización Women in International Security)

- “’Deepfakes’ pornográficos: Cuando la IA desnuda tu intimidad y vulnera tus derechos” (UOC, 2/11/23)

- ‘Deepfake Porn Is Out of Control’ (Estudio de la revista especializada WIRED, 16/ 10/2023)

- Proposición de Ley Orgánica de regulación de las simulaciones de imágenes y voces de personas generadas por medio de la inteligencia artificial (13/10/2023)

- ‘White House calls for legislation to stop Taylor Swift AI fakes’ (The Verge, 27/01/2024)

- ‘Tackling deepfakes in European policy’ (informe del Parlamento Europeo, julio 2021)

- ‘Inside the Taylor Swift deepfake scandal: ‘It’s men telling a powerful woman to get back in her box’ (The Guardian, 31/01/2024)