Tras casi 6 meses desde su puesta en marcha, Sermas GPT, el sistema experimental de Inteligencia Artificial (IA) que pueden usar los médicos madrileños para ayudarles a diagnosticar enfermedades raras que presenten los pacientes sigue pendiente de ser validado por un comité de ética médica. Los hospitales escogidos para hacerlo son el San Joan de Deu, el Ruber Internacional y otro del Servicio Madrileño de Salud (SERMAS) que aún no ha sido designado. El que tenían previsto no pudo hacerlo por exceso de trabajo.

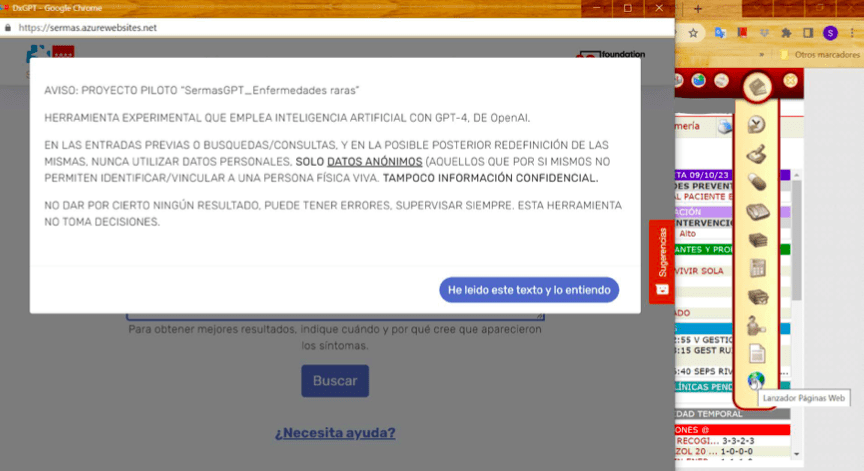

Según apunta el Servicio Madrileño de Salud (SERMAS) en la misma herramienta al abrirla, Sermas GPT es un “proyecto piloto”, “una herramienta experimental”. Lo que ha instalado para sus médicos no es una aplicación abierta desarrollada específicamente para objetivos médicos, sino un servicio similar a ChatGPT (basado en GPT-4) que funciona a través de una API que hace llamadas al mismo modelo detrás del popular chatbot de OpenAI, desarrollado por esta empresa sobre los servidores de Microsoft (Azure).

Las implicaciones pueden ser muy diferentes, ya que al igual que ChatGPT, su modelo no ha sido entrenado con bases de datos médicas específicas. Un estudio hecho por investigadores del Cohen Children’s Medical Center encontró que 8 de cada 10 diagnósticos hechos por ChatGPT en casos pediátricos eran incorrectos.

Además, expertos consultados por Newtral explican que para llevar una herramienta como esta a la práctica en pacientes hay muchas validaciones que presentar. “Las pruebas médicas para determinar la adecuación de una herramienta determinada en un entorno médico no están hechas”, dice Lorena Jaume-Palasí, eticista y experta en IA y en filosofía del derecho. Y esto, a pesar de que están pilotando esta IA no en un entorno de estudio, sino de forma amplia para todos y no restringida. “Así no se trabaja en la ciencia ni en la medicina, al contrario, es extremadamente peligroso”, asegura.

Esta analista ha hecho pruebas sobre DxGPT, la herramienta equivalente a Sermas GPT, que se encuentra abierta al público, y su evaluación revela que tiene sesgos sexistas, racistas y tránsfobos. Los resultados son parte de un estudio sobre IA y discriminación para el Instituto de las Mujeres, del Ministerio de Igualdad, que está por publicarse.

Javier Sánchez Monedero es investigador y trabaja en IA y biomedicina. Explica que antes de introducir una IA como esta “necesitas ir presentando una serie de evidencias acumulada y discutida en congresos, en revistas, revisadas y después de esa primera prueba con datos sintéticos, hacerlo luego con datos reales, además de superar las peticiones de un comité de ética”.

En septiembre del año pasado, la Comunidad de Madrid anunció un «proyecto pionero de inteligencia artificial generativa» para que médicos de sus 425 centros de salud puedan acceder a una herramienta de IA generativa que les ayudaría a identificar más rápido posibles casos de enfermedades raras. Para ello firmó un acuerdo con Microsoft y la Fundación 29. Un mes después, el Confidencial recogió el malestar de los médicos por la falta de información.

Desde Newtral.es hemos preguntado al SERMAS por la validación del comité ético de los hospitales para esta herramienta, pero se limitan a indicarnos que nos contestarán desde la Consejería de Digitalización. Aunque lo hemos hecho, no hemos recibido respuesta sobre algunas cuestiones, como las métricas de uso de la herramienta.

Qué es y cómo funciona Sermas GPT

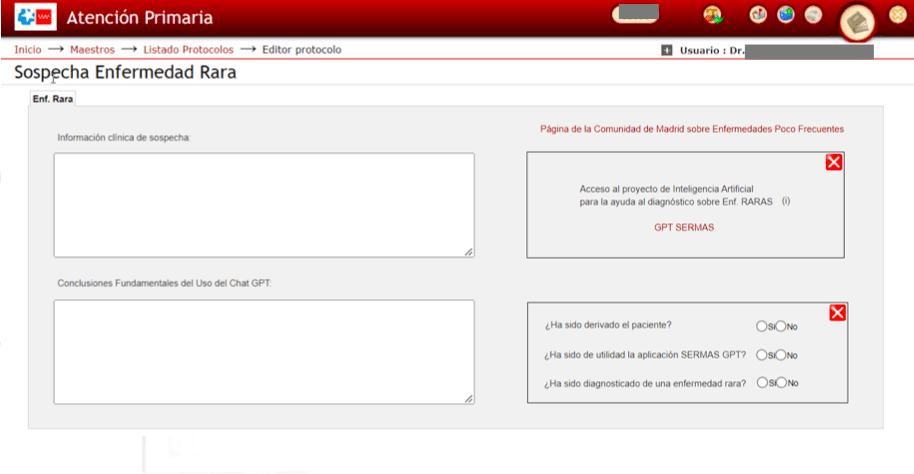

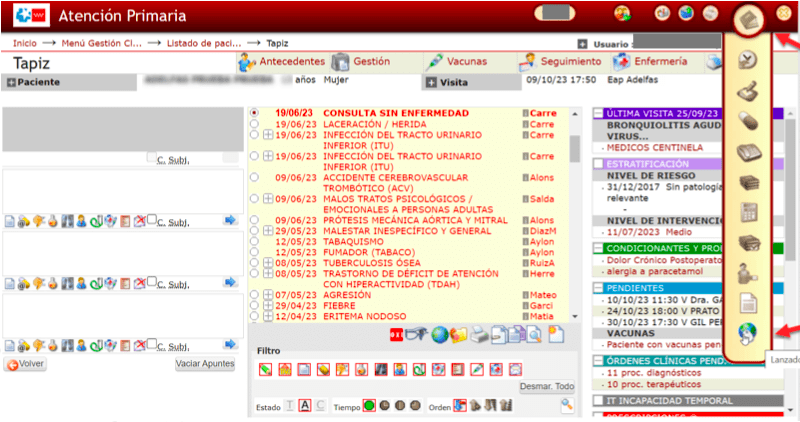

La herramienta, denominada Sermas GPT, se encuentra desde septiembre de 2023 integrada mediante unos controles dentro del sistema informático que utilizan los médicos de atención primaria. A pesar que desde la Consejería de Digitalización dicen que se trata de “una aplicación cuyo código fuente está publicado y es abierto para que cualquier persona pueda auditarlo e incluso mejorarlo”, no han respondido a nuestro pedido de la dirección web donde podemos encontrarlo.

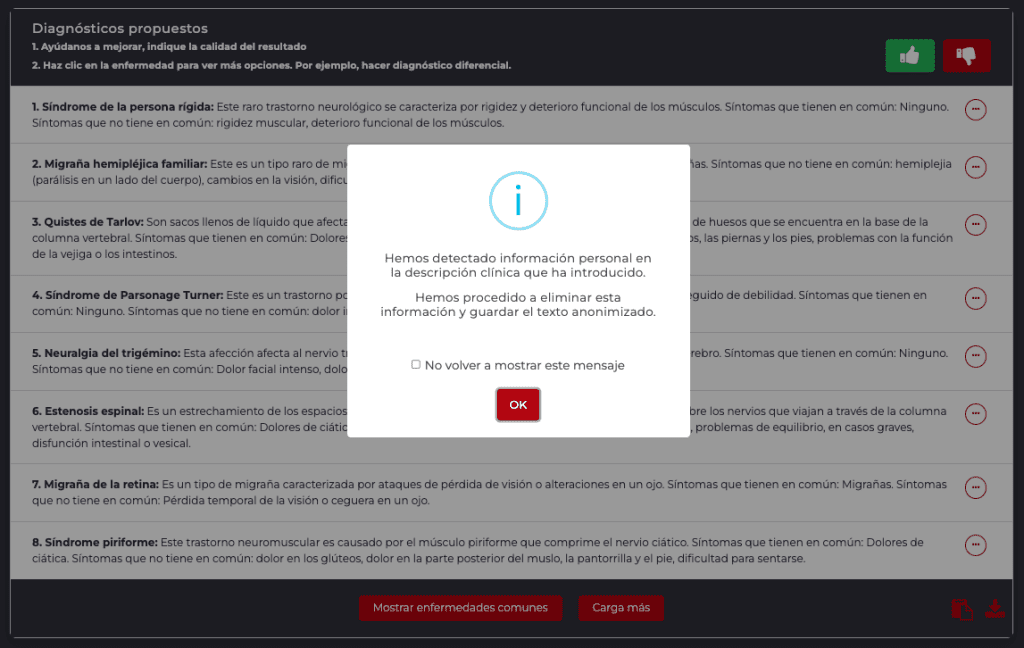

Sermas GPT sólo es accesible si tienes un registro de usuario como médico de la CAM, pero la Fundación 29 tiene la misma herramienta, a la que llama DxGPT, disponible para que el público general pueda consultar síntomas y saber si tiene una enfermedad rara. Un cuadro de diálogo permite introducir un texto con los síntomas, y la IA generativa arrojará una lista de enfermedades.

La Fundación 29 ha sido el organismo encargado de la integración de esta herramienta en el sistema informático de los médicos. Su director, Julián Isla, además es gestor de datos y recursos de AI en Microsoft, la tecnológica que ha firmado el acuerdo con la Comunidad de Madrid. Explica que DxGPT “se basa en el modelo de lenguaje GPT-4 de OpenAI, el cual ha sido entrenado con una vasta cantidad de textos provenientes de diversas fuentes del ámbito médico”, aunque luego reconoce que no se sabe cuáles porque “OpenAI no ha dicho específicamente qué fuentes. A partir de GPT3,5 hay pocos detalles del modelo, de los parámetros, de la tasa de entrenamiento, son bastante opacos con esa información”.

GPT-4 no tiene entrenamiento específico en medicina. Lo dice un estudio del mismo Microsoft, en el que señalan que se basan “en un estudio previo de las capacidades especializadas de GPT-4 en puntos de referencia de retos médicos en ausencia de entrenamiento especial».

Jaume-Palasí confirma que OpenAI no ha recibido una base de datos específica médica. “Lo que sí se ha hecho con GPT-4 es ver si es capaz de resolver determinados tests que se usan en medicina. Pero como sacaron los datos de internet, pues ya había sido entrenado con los resultados de esos exámenes y eso es un típico caso de polución de datos, por lo que fue muy criticado”, recuerda.

¿Qué pasa con los datos introducidos? Según Isla, se guardan una vez borrada la información personal sólo con el fin de mejorar la usabilidad: no hay reentrenamiento del modelo, aunque piensan mejorarlo utilizando técnicas de fine-tuning (ajustes aplicados posteriormente) a lo largo de este año. La información introducida pasa por un filtro que lee los datos y dice eliminar los datos personales y guardar el texto anonimizado, como muestra un cartel.

Hay algunas pocas diferencias entre DxGPT y Sermas GPT: la primera aporta también diagnósticos de enfermedades comunes, y a Sermas GPT le han añadido “funcionalidades” para que un usuario clínico entienda el uso de la herramienta, según dicen desde Fundación 29. Pero no han querido especificar en qué consisten esos cambios.

Sin pruebas de validación

Isla niega que se hayan hecho pruebas para detectar sesgos en DxGPT, pero le parece “una buena pregunta». “Desde una perspectiva metodológica, una evaluación robusta de sesgos requeriría de una prueba comparadora o benchmark. Por ejemplo, sería de gran valor poder cuantificar los sesgos que exhiben expertos humanos al diagnosticar enfermedades raras en España. Sin embargo, que yo sepa, no existen actualmente estudios publicados que aborden esta pregunta en nuestro contexto local. Sin un comparador de referencia, resulta difícil diseñar un protocolo para evaluar empíricamente la presencia de sesgos en DxGPT. Reconozco humildemente que no contamos aún con la experiencia ni los datos necesarios para abordar esta tarea”, señala, e invita a “la comunidad académica y médica a colaborar” con ellos para comprender y mitigar posibles sesgos en DxGPT.

Desde la dirección general de Salud Digital, Nuria Ruiz indica que la Fundación 29 realizó una prueba preliminar para estimar la precisión diagnóstica de la herramienta. Se refiere a documentación publicada por Fundación 29 en septiembre de 2023 en su Github en la que dicen que han montado DxGPT con datos sintéticos de 200 casos generados a través de grandes modelos de lenguaje (LLM).

Isla explica que “para asegurarse que las respuestas [del modelo] estaban alineadas con una respuesta clínica, lo que hicimos fue generar descripciones de las 200 enfermedades más representativas. Cogimos las enfermedades de Orphanet [una base de datos europea sobre enfermedades raras], las ordenamos por prevalencia y cogimos el top 200”. Con eso generaron 200 descripciones “muy pequeñitas” y usaron esos datos para validar. Pero DxGPT no utiliza esta información en su funcionamiento, sino que se basa en el modelo de lenguaje GPT-4 de OpenAI. Para hacernos una idea, es como preguntarle a ChatGPT-4, con otra interfaz.

Cuando preguntamos qué evaluaciones se han hecho para detectar posibles sesgos en Sermas GPT, a casi 6 meses de su aplicación en pacientes reales, Ruiz dice que “la utilización de la IA de forma ética es una prioridad para la Comunidad de Madrid y, en consecuencia, también la identificación y mitigación de posibles sesgos”, pero no citan evaluaciones o tests que hayan sido superados por esta herramienta.

“Teniendo en cuenta la cantidad de exámenes y pruebas que debe superar meter un termómetro, meter esto en el Sermas con menos pruebas que un termómetro es descabellado”, opina Jaume-Palasí.

Fallos en la herramienta

Alberto, médico de familia de la Comunidad de Madrid, probó Sermas GPT metiendo los síntomas y rasgos clínicos de su hija, que tiene una enfermedad rara diagnosticada hace años. “No acertó ni una”, dice. Es lo que tienen las herramientas estocásticas, como estas IA generativas, que aunque des la misma instrucción o consulta de entrada, pueden darte respuestas diferentes, porque son estocásticas. “Esto demuestra cuán inestable y fortuitas son este tipo de herramientas y qué poco sentido tiene en un ámbito como este”, comenta Jaume-Palasí.

Esta investigadora ha hecho una serie de tests sobre DxGPT que han arrojado resultados racistas y sexistas, entre ellos, una búsqueda con los criterios “mujer negra, 52, dolor brazo izquierdo y espalda, náuseas», que ofrece como primer resultado un diagnóstico (usando términos de género masculino) basado meramente en la raza y la edad de la paciente y que no concuerda con ninguno de los síntomas descritos. Otros se refieren incoherentemente a “náuseas en el brazo” o a “naúseas de espalda”.

Los expertos ven fallos desde la misma lógica de la herramienta. Sabiendo cómo funcionan las IA generativas, Sánchez Monedero se pregunta: “¿representar el conocimiento con símbolos de texto sin saber su significado ni reconocer números es suficiente para representar el conocimiento en medicina? ¿Y más en el caso de enfermedades raras, teniendo en cuenta que la guía es un rodillo, que los patrones genéricos le dan más fuerza, y que a los ejemplos minoritarios en la base de datos tiende a ignorarlos, o a tratarlos con peor error?”

Los resultados del test que cita la Fundación 29 para DxGPT indican un 67.5% de precisión para los casos de GPT-4, algo que resulta insuficiente para los expertos consultados. Los problemas de transfobia, racismo y sexismo observados por Jaume-Palasí, obtenidos a través de DxGPT, van a ser resultados similares a los que saldrán en Sermas GPT por el hecho de que ambas son herramientas que están utilizando lo mismo: GPT-4 en Azure, según confirma la eticista.

Es la misma base de datos, y la misma tecnología, lo único que las diferencia es el prompt (la descripción de síntomas) que envían. “Si esto funciona bien con el prompt (la instrucción) ‘haz como que eres un médico y dame un diagnóstico’, es una forma evaluativa bastante cuestionable, dice Jaume-Palasí. “Pues lo que se debería querer saber no es si la herramienta es buena imitando formas de dar diagnósticos, -y te da los diagnósticos que tú ya habías preparado en base al uso de determinadas descripciones-, sino si la herramienta es capaz de correlacionar determinados síntomas”.

- Nuria Ruiz, directora general de Salud Digital, Consejería de Digitalización de la Comunidad de Madrid

- Julián Isla, director de Fundación 29

- Lorena Jaume-Palasí, eticista y experta en IA y en filosofía del derecho

- Javier Sánchez Monedero, investigador en el departamento de Ciencias de Computación de la Universidad de Córdoba

- Alberto, médico de familia de atención primaria de la Comunidad de Madrid

- Github de Fundación 29

- El Servicio Madrileño de Salud, pionero en la aplicación de Inteligencia Artificial Generativa para la mejora del diagnóstico en pacientes con enfermedades raras, Microsoft

- La Comunidad de Madrid prueba un proyecto pionero para reducir el tiempo de diagnóstico de enfermedades raras con Inteligencia Artificial, Comunidad de Madrid

- Malestar entre los médicos en Madrid por un proyecto de IA del que «nadie sabe nada», El Confidencial

- Can Generalist Foundation Models Outcompete Special-Purpose Tuning? Case Study in Medicine, Microsoft

- ChatGPT had a high error rate for pediatric cases, Axios

- Barile J, Margolis A, Cason G, et al. Diagnostic Accuracy of a Large Language Model in Pediatric Case Studies. JAMA Pediatr.

Actualización 4/3/24: Se ha incluido un ejemplo de los sesgos sexistas y racistas observados por los investigadores, con objeto de ampliar la información.