Los humanos tenemos dos rasgos muy característicos: lenguaje y sentido común relacional. Ambos parecen interconectados y se aproximan a nuestra idea clásica de racionalidad. Pero la idea de sentido común es bastante escurridiza (y seguramente, el menos común de los sentidos, según se atribuye a Voltaire). En medio de ambos hay una cualidad que ninguna inteligencia artificial se había podido atribuir hasta ahora: generalizar sistemáticamente. Esto ha empezado a cambiar con un nuevo estudio y podría ahorrar mucho tiempo y dinero a desarrollos como ChatGPT.

Las inteligencias artificiales realizan a veces un ejercicio de aprendizaje profundo a base de exponerse a cantidades ingentes de datos. Sus cerebros artificiales se basan también en neuronas electrónicas interconectadas, pero las humanas son capaces de generar una circuitería mucho más compleja apoyada (y de la que parece que deriva) el lenguaje. Y eso nos permite aprender por ‘generalización’, lo que nos ahorra tener que leer una y otra vez instrucciones para aprender cosas nuevas cada día. Poder hacer relaciones lógicas y generalizar nos dota de sentido común. Esta ha sido durante décadas una barrera para las máquinas… hasta hoy.

Ahora, los científicos de datos Brenden Lake (psicólogo en la Universidad de Nueva York) y Marco Baroni (lingüista en la UPF de Barcelona) aportan pruebas de que las redes neuronales pueden aprender de una manera más humana, mediante lo que se llama generalización sistemática o composicional. “Lo hacemos todo el tiempo los humanos: combinar lo aprendido antes con lo novedoso; combinar partes [de información] para poder entender conceptos o a frases complejas”. Ampliando el foco, la generalización es uno de esos ingredientes que nos dotan de sentido común y que se tienden a considerar poco factibles en una inteligencia artificial.

Ni siquiera Chat GPT (y su red neuronal) parece tener sentido común

Pero, ¿cómo funciona la generalización sistemática? Un ejemplo sería tratar de imaginar un cuadrado rojo cuando sólo hemos aprendido dos cosas: qué es un cuadrado azul y qué es un círculo rojo. Como humanos, somos capaces de separar las figuras por un lado y los colores por otro. Y luego unirlos conceptualmente en la idea de un cuadrado rojo, aun no habiendo visto nunca uno. Una máquina no sabe hacer eso. “A una red neuronal artificial le tienes que enseñar todo”, explica a Newtral.es el profesor Baroni. Y solemos enseñarles a partir de palabras e imágenes. Pero la realidad (y el lenguaje) es más que eso.

Lo presentado hoy da un giro a una creencia sostenida en el campo de la inteligencia artificial durante 35 años: si una red neuronal no puede generalizar sistemáticamente, tampoco podrá ser nunca un modelo de mente humana ni una inteligencia artificial tener sentido común. Esto cambia con el modelo de entrenamiento que Lake y Baroni presentan en Nature.

Baroni no cree que implique que las IA piensen o tengan sentido común como los humanos, pero sí nos ayudará a entender cómo lo adquirimos.Publicidad

Ni siquiera las redes neuronales bajo el motor de GPT-4 “parece que hagan este tipo de generalización composicional, no está claro que incluso una de última generación como esta pueda coger una parte, coger otra y sepa como combinarlas”, sostiene Baroni, quien pone un ejemplo concreto de cómo entrenaron a su modelo de inteligencia artificial para acercarnos a esa idea de sentido común mediante generalización compositiva.

¿Implica generalizar que una inteligencia artificial pueda pensar o tener sentido común? Baroni no lo cree, “no como los humanos”. Pero “sí hemos visto que cuando nuestro sistema se equivoca no lo hace como en los resultados de ChatGPT, son errores más parecidos a los de los humanos”.

El experimento del salto doble

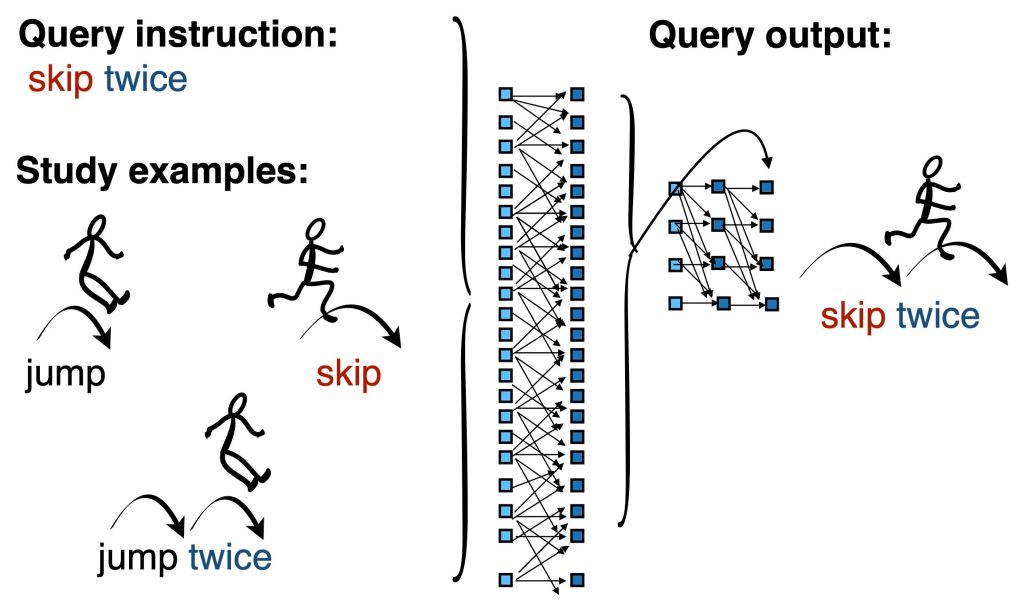

“Una máquina no sabe qué es saltar dos veces. Sabrá el concepto (y palabra) de pegar un salto, porque se lo he enseñado. Sabrá el concepto de brincar. Sabrá el concepto de dos veces”, señala. Pero no sabrá qué es dar un doble salto consecutivo a menos que tú le enseñes a brincar dos veces, en cuyo caso aprenderá un tercer término: “brincar dos veces”. En realidad, los humanos no aprendemos así, no tendríamos que crear ese tercer elemento. “Nos basta con generalizar, con unir la idea de saltar y dos veces”. Pues bien, Baroni y su colega han conseguido que una inteligencia artificial comprenda qué es eso de dar un doble salto consecutivo sin enseñarle un doble salto consecutivo. Generalizando, un poco por ‘sentido común’.

Buena muestra de lo complejo que puede resultar para una máquina es ver que nos resulta difícil a los hispanohablantes entender el experimento concreto, pues usaron las palabras inglesas jump (saltar) y skip (que también es saltar, pero como brincando, como lo haría un cordero).

Esto es importante, por ejemplo, de cara a dar instrucciones a un robot dotado de un cerebro artificial. No haría falta enseñarle todos los modos de salto. Podría entender que si le decimos saltar hacia atrás, entenderá que quiere un salto de espaldas, incluso aunque nunca haya visto u oído hablar de uno de esos saltos. Podrá generalizar. Una vez más, esto también es algo de sentido común aplicado a una inteligencia artificial, aunque a los humanos nos pase desapercibido.

Dime DAX CUC y te diré Ucrania

Otro de los experimentos de Baroni pasaron por enseñar palabras de un idioma que no existe a personas y a su red neuronal artificial. “Yo puedo decir que DAX significa amarillo y CUC, azul. Entonces, pregunto a las máquinas y a los humanos ¿qué significa la frase DAX CUC?, al principio, el modelo de inteligencia artificial daba respuestas sin sentido, pero tras el entrenamiento daba la misma respuesta que los humanos: Amarillo azul”. Un siguiente nivel relacional sería ligarlo a la idea de Ucrania o Suecia, por ejemplo, por su bandera [esta ya no se hizo en el experimento]. “Es curioso, porque asocial el azul y amarillo a la bandera de Ucrania es más fácil para una red neuronal porque se lo han enseñado, seguramente se haya aprendido las banderas del mundo”.

Sin embargo, se las ha aprendido de memoria, algo así como la frase “la bandera ucraniana es azul y amarilla”, sin entender muy bien que esos colores son conceptos que pueden estar en otros sitios y son lo mismo. El salto que proponen estos autores va más en esta línea, la de poder llegar un día a entender naturalmente que esos colores se liguen a Ucrania o a Suecia, por ejemplo.

Un paso para entender cómo aprendemos los humanos

En 1988, investigadores argumentaron que las redes neuronales carecen de esta capacidad y, por tanto, no son modelos fiables de cognición humana y descartaban la idea de que una inteligencia artificial pudiera desarrollar algo parecido a sentido común. A pesar de los importantes avances de las décadas siguientes, las redes neuronales todavía luchan por demostrar una capacidad de generalización sistemática.

Valora Teodoro Calonge, profesor de Informática en la Universidad de Valladolid, que el trabajo de Baroni es “ingenioso, porque desde las redes neuronales artificiales (ANN) se intenta dar una explicación de cómo funcionan ellas mismas, de ahí el prefijo ‘meta’ [en el título del artículo]. Sin embargo, lo que hace realmente es comparar la capacidad de predecir de las redes neuronales generativas (como GPT) con la de los humanos –afirma al SMC de España–. Para ello monta una batería de pruebas basadas en la psicología, esto es, trata de comparar la respuesta de las GAN con las obtenidas en los equivalentes estudios psicológicos con humanos acerca de la inteligencia”.

Baroni cree que este tipo de trabajos sirven, en buena medida, para acercarnos a interrogantes más humanos que cibernéticos. Si entendemos cómo aprenden o adquieren el lenguaje las máquinas quizás podamos saber cómo lo hacemos los humanos. Y por qué necesitamos palabras, incluso para pensar en conceptos abstractos o matemáticos. “Sigue siendo una de las grandes preguntas por terminar de responder”.

- Estudio de Lake y Baroni en ‘Nature’, 2023

- Marco Baroni (ICREA-UPF)

- Brendan Lake (Univ. de Nueva York)

- Teodoro Calonge (Univ. Valladolid)

Newtrolas y sus sandeces.