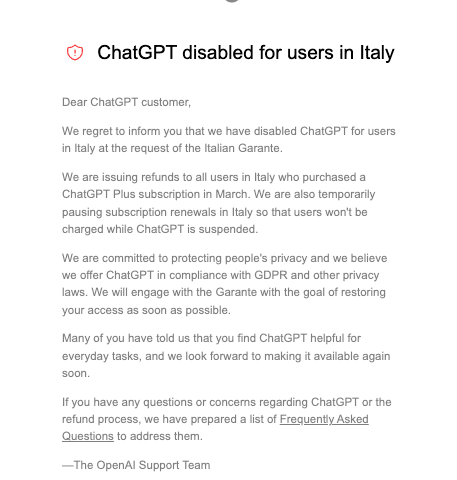

OpenAI ha bloqueado el acceso desde Italia a ChatGPT a través de geolocalización y reembolsará a sus clientes italianos que hayan comprado una suscripción en marzo. La acción es causa directa del aviso que ha dado la autoridad de protección de datos de Italia a la empresa dueña de ChatGPT, OpenAI, el viernes pasado de limitar temporalmente el tratamiento de datos de usuarios italianos. Mientras, Italia investiga si esta empresa está cometiendo una infracción de la normativa de protección de datos europea.

OpenAI asegura que creen estar cumpliendo con el RGPD y otras leyes sobre la privacidad y que se comprometen a colaborar con las autoridades italianas. Lo hacen a través de un aviso que salta a todo usuario que ingrese a la web de ChatGPT desde suelo italiano y en el que avisan del bloqueo temporal y del reembolso.

En la empresa dirigida por Sam Altman tienen razones para mostrarse colaborativos. Si en 20 días no comunican oficialmente las medidas que adoptan en ejecución de lo solicitado por la agencia de protección de datos, pueden recibir una multa de 20 millones de euros o hasta el 4% de su facturación global anual, lo que sea mayor.

En Newtral.es hemos analizado con juristas el impacto que tiene ChatGPT en torno a la privacidad, ya que hay varios tratamientos de datos personales en juego: los relacionados con el registro de los usuarios de la web, las instrucciones o textos que le damos en conversaciones con el chatbot, y los textos que genera, entre los que se encuentran errores y falsedades.

Alemania, Francia, Canadá y otras agencias interesadas en investigar a ChatGPT

El bloqueo y la investigación desde Italia llegan apenas unos días después de que dos importantes organizaciones de la sociedad civil pidan investigar a ChatGPT por protección de datos y su impacto en los consumidores. En Estados Unidos, el Centro para la Inteligencia Artificial y Política Digital (CAIDP) presentó una denuncia ante la Federal Trade Commission (la comisión de comercio) contra ChatGPT-4, a la que siguió un requerimiento de la Organización Europea de Consumidores (BEUC, un grupo de 46 organizaciones independientes presente en 32 países) a la Unión Europea y todas sus autoridades nacionales para investigar esta empresa y chatbots similares. Por otro lado, la autoridad canadiense de Protección de Datos ha lanzado una investigación sobre ChatGPT por recolección, uso y revelación de datos personales sin consentimiento.

Hay otros aspectos demás de la protección de datos, explica a Newtral.es David Martin Ruiz, de BEUC, ya que esta tecnología se puede usar para manipular más fácilmente la conducta de un consumidor. Creen que al extenderse la funcionalidad de la IA en diferentes productos tan rápidamente es necesario hacer una investigación detallada del impacto y los riesgos de los consumidores. Por eso, después de este requerimiento general no descartan hacer alguna denuncia particular o alguna carta a una autoridad en concreto.

El Garante Italiano para la Protección de Datos Personales es una autoridad administrativa independiente similar a la Agencia Española de Protección de Datos (AEPD) en nuestro país, que ha actuado por su cuenta.

La agencia española ha solicitado por su parte que este asunto se incluya en el próximo Plenario del Comité Europeo de Protección de Datos, que se celebrará en abril. “Entendemos que los tratamientos globales que pueden tener un importante impacto sobre los derechos de las personas requieren de decisiones coordinadas a nivel europeo, de forma que se puedan poner en marcha acciones armonizadas en el marco de aplicación del Reglamento General de Protección de Datos”, explican desde la AEPD a Newtral.es.

Aunque OpenAI no tiene oficina en la Unión Europea, ha designado un representante en Irlanda, con lo cual si se siguiera el mecanismo de ventanilla única, el procedimiento contra ChatGPT en Europa debería liderarlo la autoridad de protección de datos en ese país. “Es conocido por todos que este mecanismo no funciona al 100%, por lo que las distintas autoridades nacionales pueden llevar por su cuenta los procedimientos”, señala Jeimy Poveda, consultora del grupo de expertos en privacidad de Secuoya Group.

El Comisario alemán de Protección de Datos dijo al periódico Handelsbatt que su país podría seguir los pasos de Italia, y que les han pedido información sobre la investigación contra ChatGPT, según reporta Reuters. Los organismos de protección de datos de Francia e Irlanda dijeron que también se han puesto en contacto con el regulador de datos italiano para discutir sus conclusiones.

Qué imputa la agencia italiana de protección de datos a ChatGPT

La agencia italiana, que ha actuado de manera independiente, ha señalado “la falta de información a los usuarios y todas las personas interesadas” cuyos datos son recogidos por OpenAI para el funcionamiento de ChatGPT, y denuncia “la ausencia de base jurídica que justifique la recogida y almacenamiento masivos de datos personales con el fin de ‘entrenar’ los algoritmos que gestionan el funcionamiento de la plataforma”.

Uno de los miembros del consejo del Garante, Guido Scorza, ha hablado con el diario La Repubblica y resume lo que la autoridad italiana imputa a OpenAI: “En particular, tres violaciones diferentes: haber recopilado los datos personales de miles de millones de personas para entrenar sus algoritmos sin informarles de esta circunstancia y, probablemente, sin tener una base legal adecuada; recopilar datos personales de los usuarios durante las conversaciones sin informarles del destino de estos datos; y generar contenidos, en respuesta a preguntas, que en ocasiones atribuyen a las personas hechos y circunstancias inexactas y falsas, proponiendo así una representación distorsionada de su identidad personal”.

No es sólo eso. Además de la falta de información en cuanto al tratamiento y la protección de datos, Scorza añade otro tema: “con ChatGPT y los chatbots tenemos conversaciones, y en esas conversaciones muchas veces tendemos a compartir mucho de nuestra vida”.

Basándose en comprobaciones efectuadas, dicen que la información que genera ChatGPT “no siempre se corresponde con los datos reales”, lo que “da lugar a un tratamiento inexacto de los datos personales”. Scorza pone un ejemplo concreto de su impacto: “Si le pregunto al chatbot cuándo se afilió Guido Scorza al colegio de Garantes de la Privacidad me dice que en 2016. Pero yo me colegié en 2020. No hay nada malo en este caso, pero si en cambio dijera que atropellé a un niño en un paseo marítimo y luego me escapé y ese hecho no era cierto, destruiría mi vida para siempre”.

El Garante también observa que ChatGPT expone a los menores a respuestas “absolutamente inapropiadas para su edad y conciencia”. Aunque OpenAI indica en sus términos de uso que el servicio está dirigido a mayores de 13 años, la empresa no provee ningún tipo de mecanismo que verifique la edad de sus usuarios.

Qué leyes protegen a los usuarios de ChatGPT en Europa

El comisario europeo de Mercado Interior, Thierry Breton, ha recordado que Europa trabaja en una propuesta de reglamento sobre inteligencia artificial, también conocida como la AI Act, que fue presentada hace dos años y que busca proporcionar a desarrolladores, implementadores y usuarios de IA requisitos y obligaciones claros en relación con los usos específicos de la IA”, según la propuesta de la Comisión. Según fuentes parlamentarias europeas citadas por El País, la presentación del plan y su votación están en la agenda de la Eurocámara para la última semana de abril, lo que significaría que podría entrar en vigor en 2025.

Los plazos son demasiado largos para la Organización Europea de Consumidores (BEUC), que cree que llevaría “por lo menos 4 años” que esta normativa haga efecto, dejando a los consumidores en riesgo de daños por parte de una tecnología que no está lo suficientemente regulada. Por el momento, según Martín Ruiz, hay un vacío legal, y el hecho de que muchas empresas en sectores como las finanzas o las compras en línea estén integrando ChatGPT y estas tecnologías en diferentes productos comporta mayores riesgos, aún más que los relativos a protección de datos.

“ChatGPT tiene ciertas características que se asemejan mucho más a lo que puede ser una relación con una persona, lo que lo hace mucho más peligroso a la hora de manipular o influenciar de manera subrepticia a los consumidores”, dice Martín Ruiz y cita el caso de un hombre joven belga que recientemente se suicidó después de mantener una serie de charlas intensivas con un chatbot basado en un gran modelo de lenguaje similar a ChatGPT. El ejemplo, según admite Martín Ruiz, es extremo, pero según él da a entender a qué tipo de problemas se refieren con problemas de seguridad pública.

En BEUC no se refieren tanto a la página web de ChatGPT en OpenAI sino a todos los usos y servicios que incluirán funcionalidades de IA a partir de ahora, como Klarna, que ofrece recomendaciones de compra, o Microsoft que lo está integrando en todos sus productos.

¿Cómo de protegidos estamos por la normativa de privacidad europea ante este tipo de productos de las IA generativas? El artículo 22 de la GDPR sobre decisiones automatizadas tiene muchas lagunas, porque tiene una serie de excepciones que hace que no siempre se aplique, según Martín Ruiz. “Como aquí ya hay prácticas comerciales, estamos mirando otras áreas como las leyes de protección de los consumidores”, explican desde BEUC. Consideran que habrá mucha legislación sectorial que se aplicará, porque por ejemplo si los bancos comienzan a utilizar IA en sus productos, habrá leyes bancarias y de seguridad de los productos que entrarán en juego.

¿Qué deberá hacer OpenAI? Martín Ruiz está seguro de que sólo en el entrenamiento de ChatGPT hubo recogida y tratamiento de datos personales, y no ve cómo pueden cumplir, por ejemplo, con lograr el consentimiento de todas esas personas en 20 días. “Tendrían que pedirlo por ejemplo a todas las personas que han escrito algo en internet en los últimos 20 años”, dice.

Poveda recuerda que “este tipo de proyectos deben cumplir con amplios requerimientos de transparencia e información, tener una legitimación adecuada para cada uno de los tratamientos de datos que realizan, y en general cumplir con toda la normativa tanto sectorial como de protección de datos que aplica”. Los retos “son enormes”, dice, y espera que la normativa en la que trabaja la UE sobre IA permita el desarrollo de la tecnología a la vez que protege nuestros derechos y libertades.

- David Martin Ruiz, jefe del equipo digital de la Organización Europea de Consumidores

- Jeimy Poveda, consultora senior y miembro fundadora del Grupo de Expertos en Privacidad Secuoya Group

- Aviso del Garante per la Protezioni di Dati Personali

- Scorza (Garante Privacy): «Contro OpenAI e ChatGpt provvedimento d’urgenza», La Repubblica

- Belgian man dies by suicide following exchanges with chatbot

- Bruselas quiere que los contenidos generados por inteligencia artificial lleven una advertencia específica

- Propuesta de normativa en inteligencia artificial de la UE

- OPC launches investigation into ChatGPT

Foto: Olaf Meister, CC BY-SA 4.0, via Wikimedia Commons