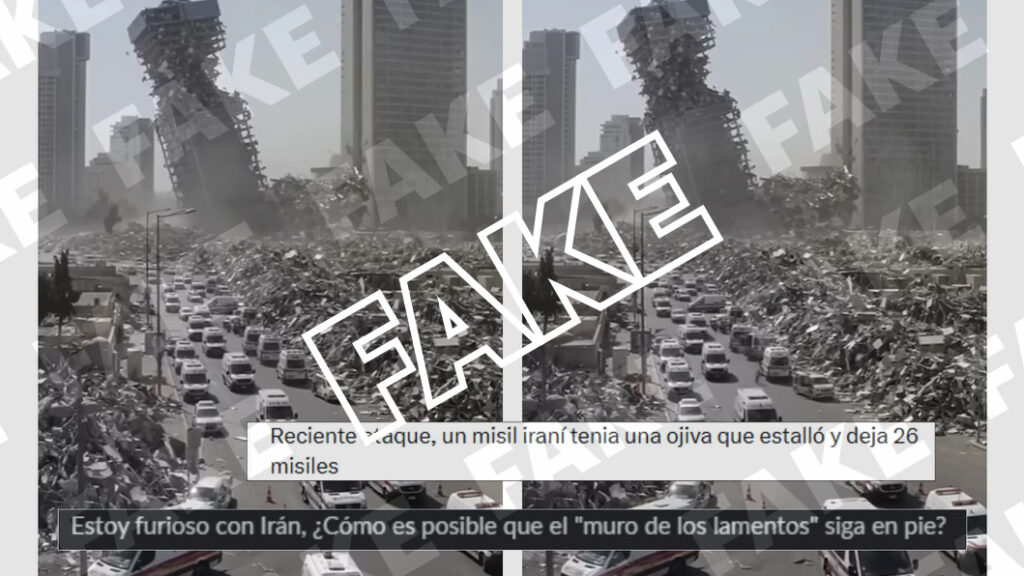

Publicaciones de redes sociales comparten un vídeo de una ciudad devastada con un edificio a punto de derrumbarse y decenas de ambulancias circulando entre los escombros. Algunos mensajes relacionan las imágenes con un supuesto ataque con misiles de Irán a Israel. Pero es falso, se trata de un vídeo generado con inteligencia artificial.

- Otros posts compartidos en inglés aseguran que es el resultado de los ataques del presidente estadounidense, Donald Trump, en Irán.

Contexto. Israel lanzó el 13 de junio una ofensiva sobre Irán que mató al jefe de la Guardia Revolucionaria, mandos militares y científicos de alto rango. Desde entonces, ambos países han intercambiado ataques con misiles. El 22 de junio, se produjo otra escalada del conflicto cuando Estados Unidos bombardeó tres instalaciones nucleares iraníes.

[Los bulos sobre los ataques entre Israel e Irán de junio de 2025]

Cómo determinamos que es IA. Una búsqueda inversa en Google Imágenes muestra una publicación de YouTube que, según los metadatos del post, fue publicada el 20 de junio. Este es el primer registro del vídeo viral, erróneamente atribuido al lanzamiento de un misil iraní en Israel, que hemos hallado en Newtral.es. La cuenta que lo compartió se llama Gen Next AI y la descripción del post incluye los hashtags #ai y #funnyai (“IA divertida” en español).

- El usuario indica en su perfil que por ejemplo publica “ideas creativas de contenido generado con IA”.

- Esta cuenta de YouTube fue creada el 29 de mayo de 2025 y compartió otro vídeo similar al viral con varias ambulancias circulando en una escena con un edificio derruido.

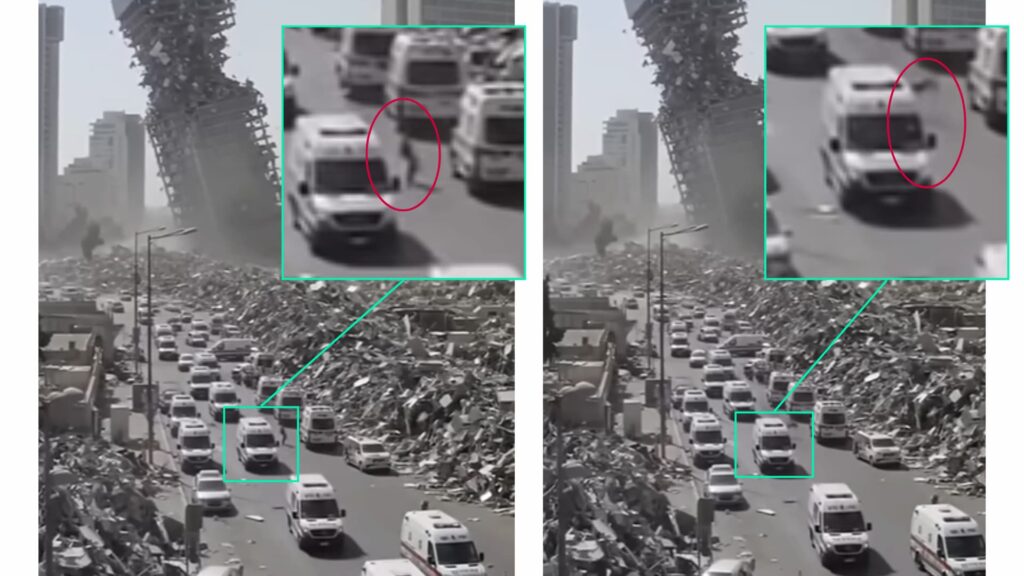

Más indicios de IA. Otros detalles del vídeo del presunto ataque iraní a Israel también apuntan a que ha sido generado con inteligencia artificial, pues las imágenes presentan errores que son comunes en los contenidos creados con esta herramienta.

- Por ejemplo, se distinguen “personas” al lado de las ambulancias que aparecen de forma intermitente como si fueran sombras o figuras en estado gaseoso.

- Asimismo, hacia el final del vídeo, se abren las puertas de varias ambulancias situadas en una fila de los laterales y los vehículos se deforman y emborronan.