«Pausen los experimentos gigantes de inteligencia artificial (IA)». Es el grito de alerta de un grupo de expertos en computación, que a finales de marzo titularon de esa manera una carta abierta en la que advirtieron de los riesgos que conllevan estas tecnologías. Quienes la firmaron consideran que desplegar “mentes digitales” traerá consecuencias «cada vez más poderosas»; algo que «nadie −ni siquiera sus creadores− puede entender, predecir o controlar de forma fiable». “La IA avanzada podría representar un cambio profundo en la historia de la vida en la Tierra, y debería planificarse y gestionarse con el cuidado y los recursos adecuados”, plantearon.

No son los únicos. La Agencia Española de Protección de Datos ha anunciado que investiga a ChatGPT por «posible incumplimiento de la normativa», e Italia ha bloqueado su uso por ese mismo motivo.

El potencial de la inteligencia artificial para la desinformación

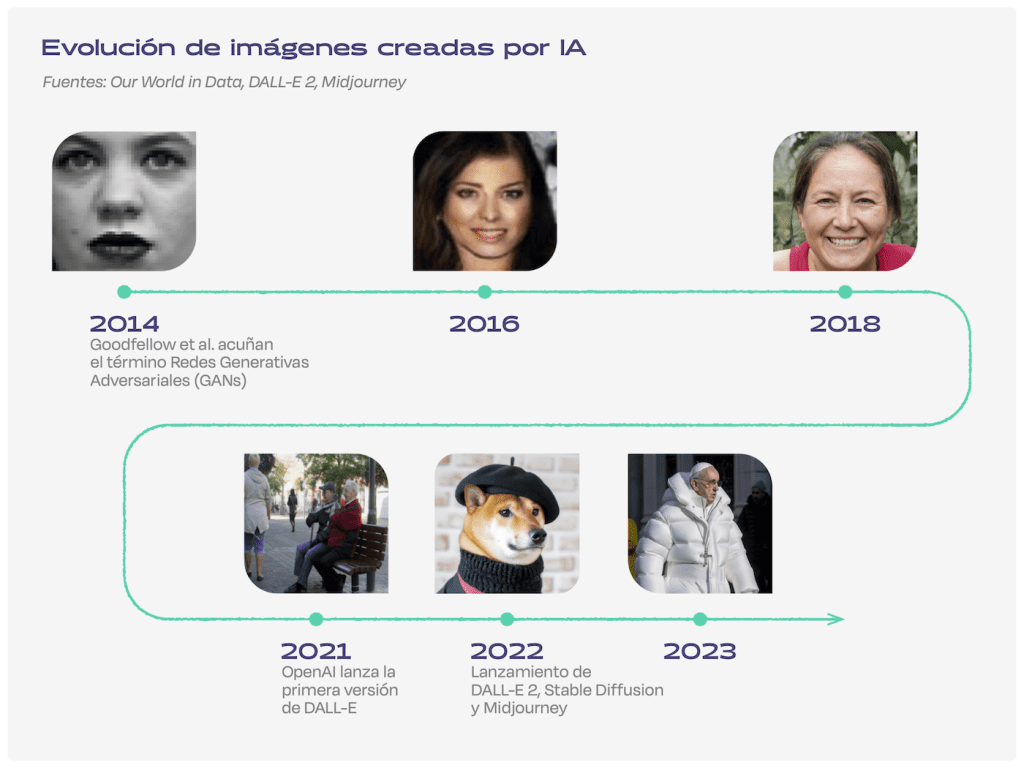

En el campo de la desinformación, los riesgos son evidentes. En las últimas semanas se han difundido imágenes creadas con inteligencia artificial generativa del papa vestido con un abrigo acolchado, del expresidente estadounidense Donald Trump arrestado o del mandatario ruso, Vladímir Putin, arrodillado ante su homólogo chino, Xi Jinping. Solo unos días después aterrizaron también en la política nacional, con una imagen generada de Pablo Iglesias y Yolanda Díaz en la portada de un diario nacional.

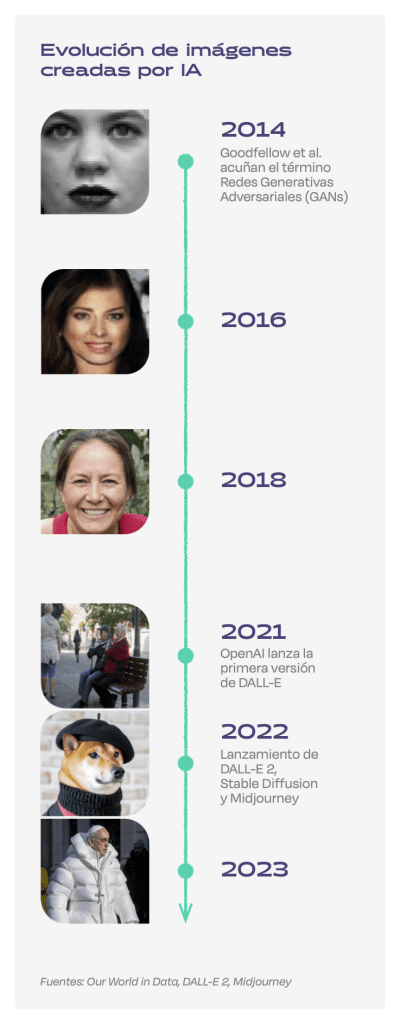

La calidad de las imágenes creadas con inteligencia artificial generativa ha evolucionado tanto que algunos pronostican que pronto será difícil distinguirlas con técnicas forenses manuales, y los expertos temen los peligros que esto puede suponer. «La información generada con inteligencia artificial es cada vez más perfecta. Llegará un punto en el que no vamos a poder saber qué es cierto o no», asegura a Newtral.es Ricardo Baeza-Yates, director de investigación del Instituto de IA Experiencial de la Universidad Northeastern. «Esto va a hacer que toda nuestra interacción con la información se quiebre y solo podamos creer en personas físicas. La desinformación va a aumentar por mil veces, y eso va a afectar a la democracia», afirma.

Es en este punto en el que algunos se plantean la necesidad de detener los desarrollos hasta poder asegurar que los nuevos sistemas de IA sean seguros y sus riesgos controlables, como citan en la carta.

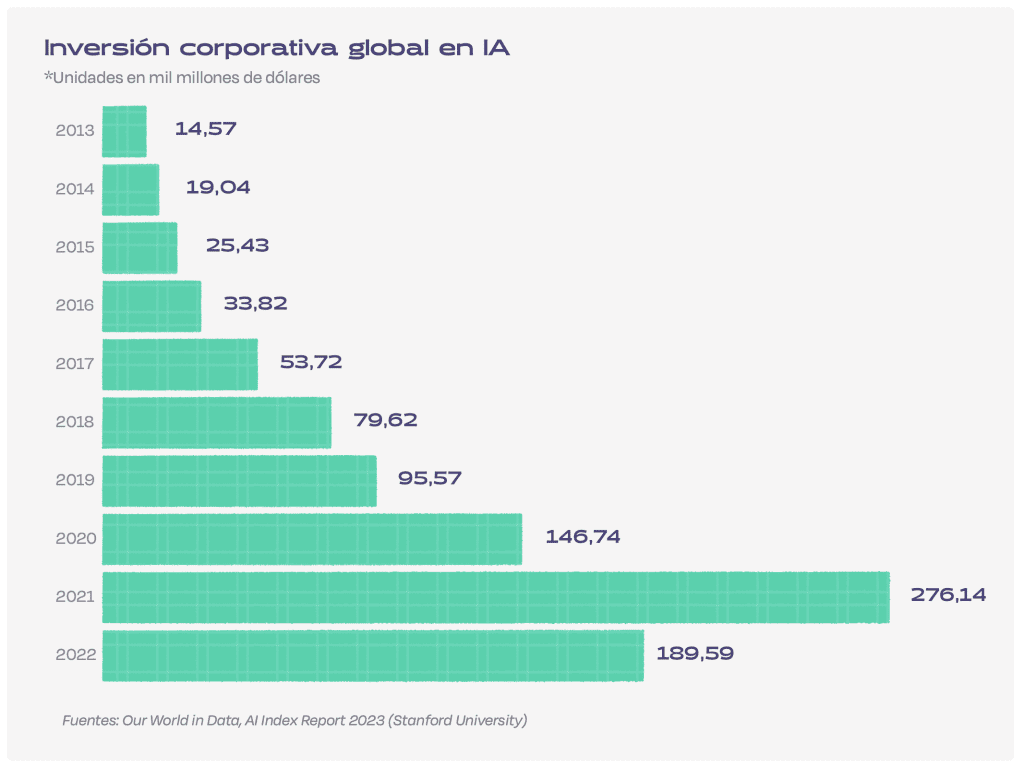

La inversión en inteligencia artificial se multiplica por 13

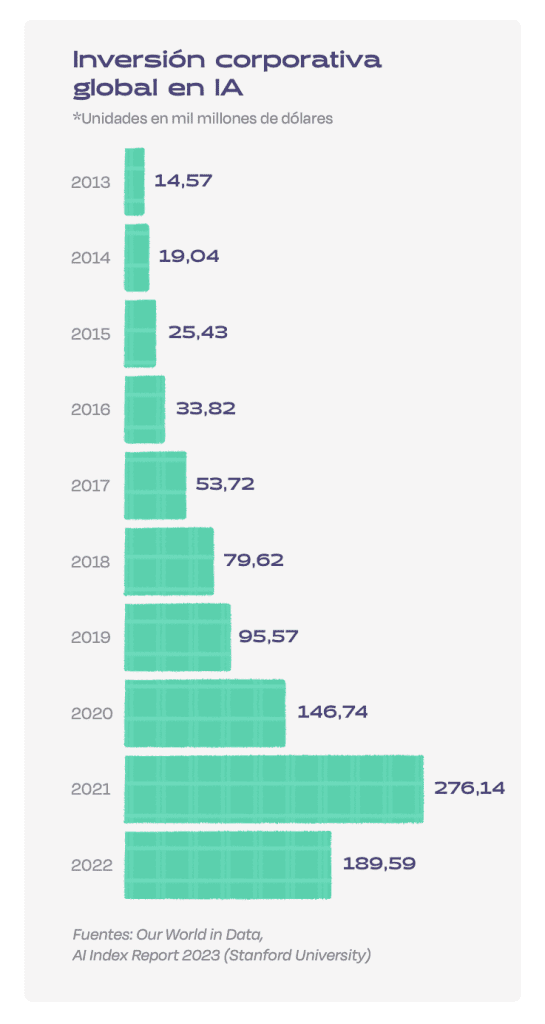

Pese a ello, la carrera que han emprendido los principales laboratorios de desarrollo de inteligencia artificial parece lejos de poder frenarse. En 2021, la inversión corporativa en IA sobrepasó los 270.000 millones de dólares, su máximo histórico. Aunque en 2022 se reportó un gasto menor al año anterior, en la última década la inversión se ha multiplicado por 13, como recogen los datos de Stanford y Our World in Data.

Estos informes también revelan que los equipos de investigación han dejado de estar dominados por la academia y han pasado a manos de la industria. «Montar un sistema de IA requiere, como mínimo, estar cinco años estructurando datos. Este tipo de inversión solo se la pueden permitir las grandes compañías tecnológicas, no las pymes, que constituyen el 99% de las empresas de la Unión Europea«, critica Lorena Jaume-Palasí, fundadora y directora ejecutiva de The Ethical Tech Society.

Cronología de los desarrollos en IA

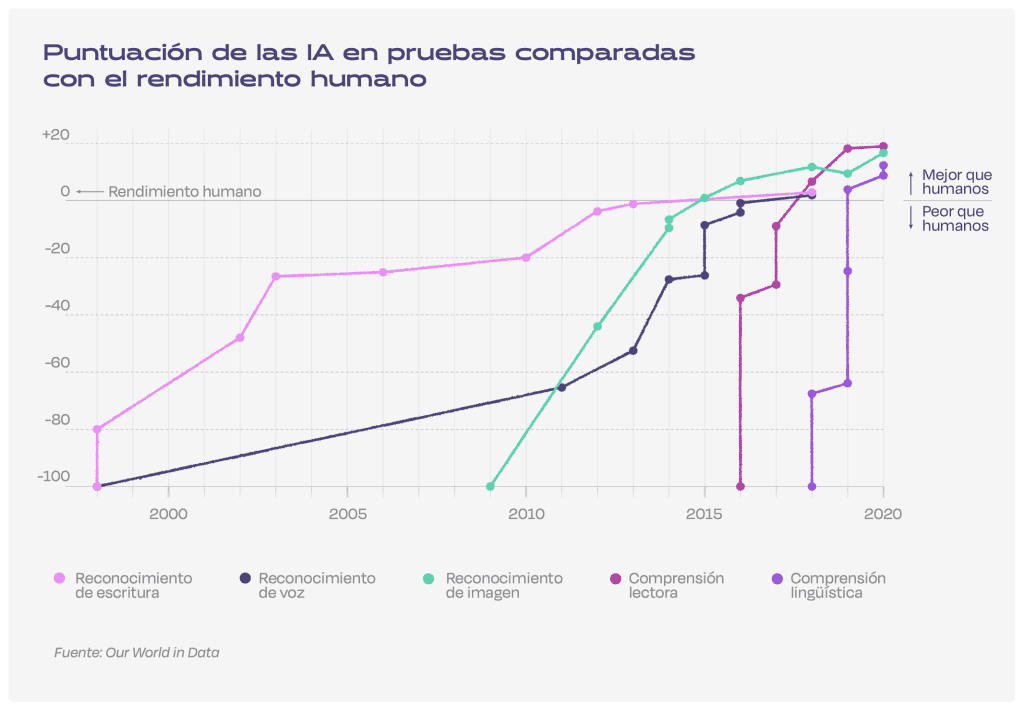

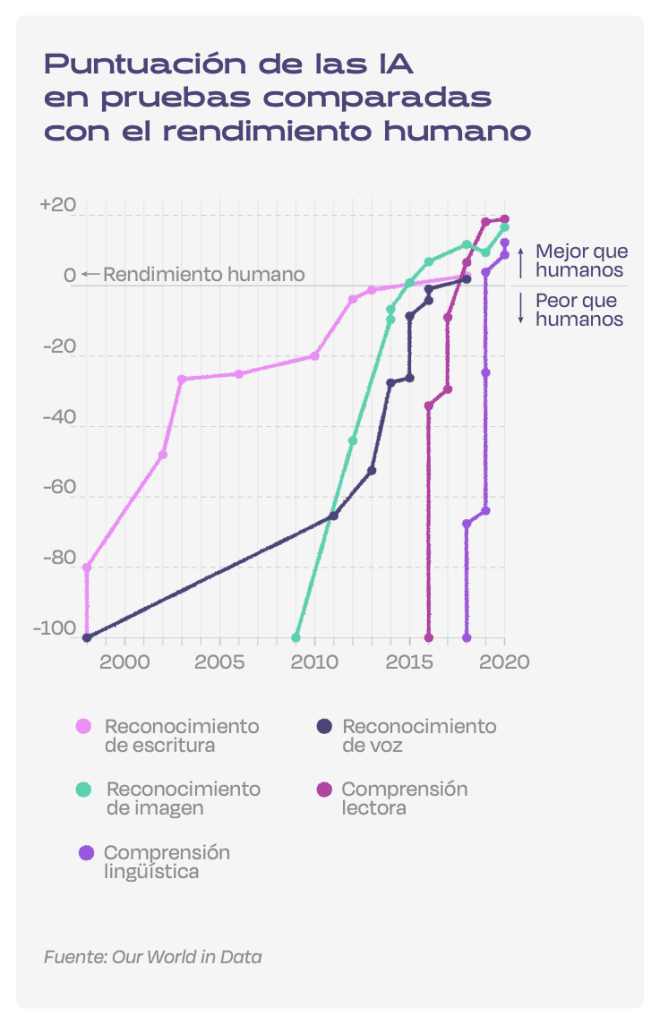

En los últimos 20 años, la inteligencia artificial ha ido superando el rendimiento humano en varios ámbitos, «desde el reconocimiento de la escritura hasta la comprensión del lenguaje», como recoge Our World in Data, la organización de análisis y visualización de datos de la Universidad de Oxford. “Hace apenas 10 años, ninguna máquina podía ofrecer de forma fiable un reconocimiento lingüístico o de imágenes a nivel humano”, describe en su análisis. Ahora, esto está al alcance de algunos clics.

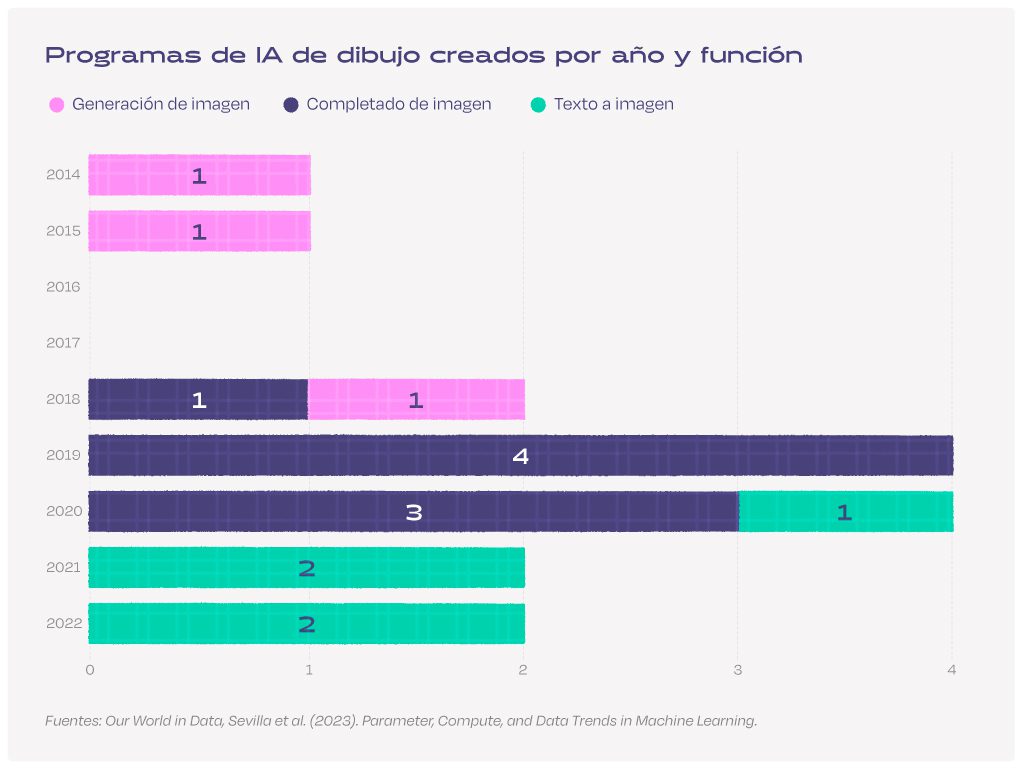

En varios casos, la evolución de la tecnología ha permitido pasar del reconocimiento de texto o de imágenes a su propia generación. Aunque parece un juego de palabras, el cambio es radical: en 2017, los sistemas de inteligencia artificial generativa ya podían crear imágenes de forma verosímil de personas que no existían, haciendo difícil distinguir entre una foto real y otra que no lo era. Pero en los últimos años, estos modelos han aprendido a generar imágenes a partir de una descripción de texto, obteniendo representaciones aparentemente reales de lo que cualquier usuario quiera imaginar.

Tecnologías como DALL-E, Stable Diffusion o Midjourney han revolucionado el dominio del dibujo en las inteligencias artificiales generativas, al mismo tiempo que han revelado dilemas éticos en torno a su utilización para la difusión de noticias falsas y sobre su autoría.

Los costes del desarrollo de la inteligencia artificial

OpenAI, la empresa que creó ChatGPT, la famosa aplicación de generación de texto conversacional que se ha popularizado en los últimos meses, asegura en su web que su misión es “garantizar que la inteligencia artificial general −sistemas de inteligencia artificial que suelen ser más inteligentes que los humanos− beneficie a toda la humanidad”. Pero, por ahora, hay pocas garantías de que esto vaya a ser así.

«El argumento de que la IA tiene riesgos y beneficios resulta muy dañino, ya que sus beneficios están aún por demostrar, mientras que sus costes ya han emergido», afirma Jaume-Palasí. «La IA necesita una cantidad impresionante de materias primas no renovables y de las que apenas tenemos reservas en el continente europeo. Su extracción implica un cierto grado de ecocidio en países del sur global», apunta.

Esto se une a que el procesamiento de datos por parte de estos sistemas requiere «una cantidad de energía ingente», que equivale a «la que utilizarían cinco coches en todo su ciclo de vida», mientras que su mantenimiento implica que “millones de personas tengan que encargarse de comprobar y corregir el sistema a diario, realizando un trabajo muy monótono con el que no pueden explotar todo su potencial”, añade.

Otra amenaza relacionada con estos sistemas tiene que ver con su funcionamiento en situaciones potencialmente peligrosas, como la conducción autónoma, o discriminativas, como la automatización de decisiones judiciales.

72 incidentes con inteligencias artificiales registrados en 2022

La iniciativa AIAAIC (siglas de «AI, Algorithmic and Automation Incidents and Controversies») ha contabilizado 72 incidentes o problemas relacionados con inteligencias artificiales en 2022, siete veces más que en 2012. Entre ellos, describen la creación de deepfakes en Venezuela para ‘crear’ dos supuestos presentadores de noticias que ensalzaban la calidad de la economía venezolana en la televisión estatal o el suicidio de una persona tras mantener una relación con un chatbot, según recoge AIAAIC.

«La inteligencia artificial sirve para automatizar procesos, y como en todo proceso de automatización, se produce un cierto porcentaje de errores que se acepta», afirma Carles Sierra, director del Instituto de Investigación en Inteligencia Artificial (IIIA) del Consejo Superior de Investigaciones Científicas (CSIC).

Muchos de estos incidentes tienen que ver con «fallos en el proceso de diseño». Por ejemplo, «cuando los sistemas son entrenados con conjuntos de datos sesgados, en los que la muestra tiene falta de representatividad, ofrecen recomendaciones que no son correctas. Los ingenieros tienen que ser muy cuidadosos para evitar estos sesgos», explica.

Los gobiernos comienzan a legislar sobre inteligencia artificial

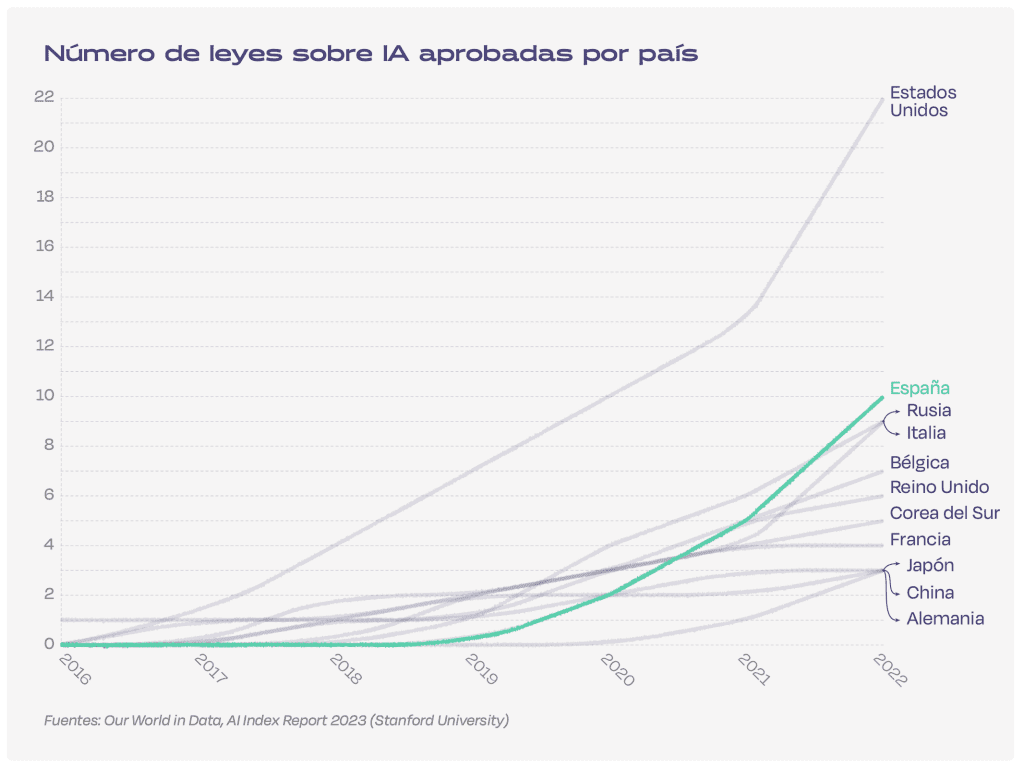

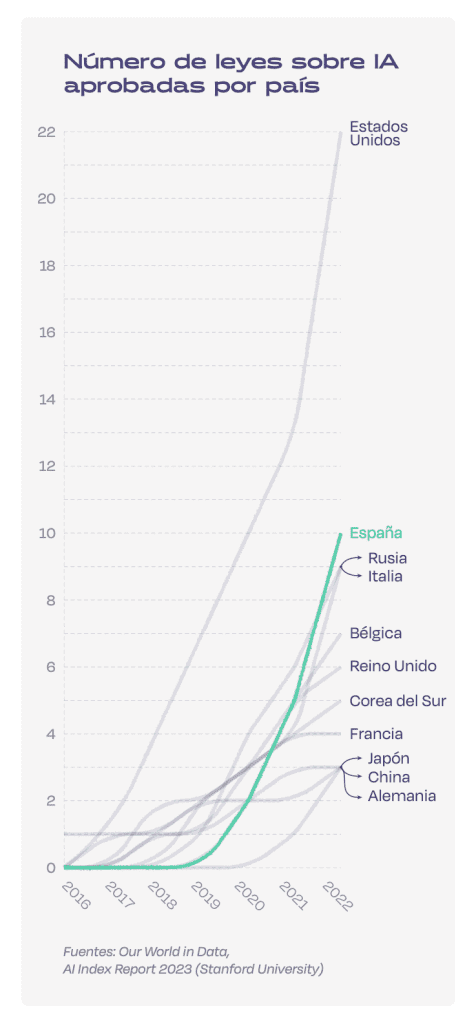

La preocupación por estos riesgos se ha extendido también al ámbito legal: el número de proyectos de ley sobre inteligencia artificial ha crecido significativamente desde 2016. Según el último informe sobre inteligencia artificial de la Universidad de Stanford, en 2022 Estados Unidos y España fueron los países que impulsaron el mayor número de proyectos de ley relacionados con la IA, con nueve y cinco leyes, respectivamente. La Comisión Europea presentó en abril de 2021 su propuesta de Ley de Inteligencia Artificial, un documento de 108 páginas que aún está siendo debatido por el Parlamento Europeo.

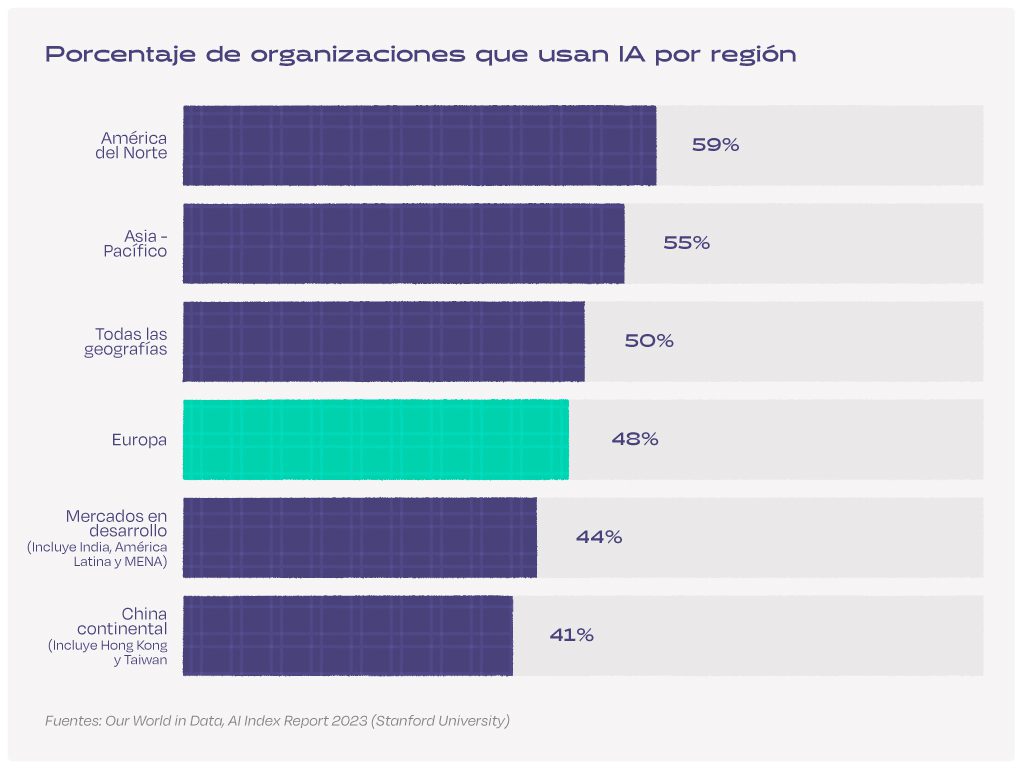

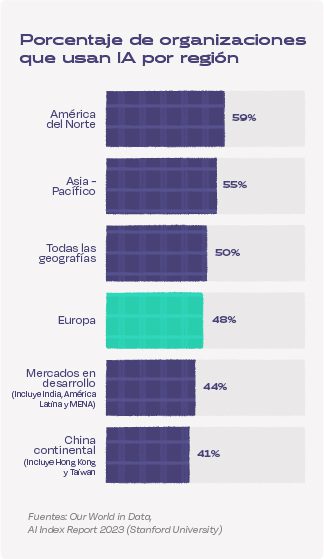

El afán por regular el desarrollo y la aplicación de estas tecnologías responde a la amplia adopción que están teniendo en todo el mundo. El año pasado, el 50% de las organizaciones incluidas en la encuesta realizada por McKinsey reportan su utilización en al menos una unidad de negocio. En América del Norte y Asia-Pacífico, más de la mitad de las encuestadas reportaron incorporarlas en sus procesos. En las organizaciones europeas este porcentaje está dos puntos por debajo de la media.

«La Unión Europea y los Gobiernos nacionales tienen que legislar para parar la guerra en la que han entrado las corporaciones por la que están sacando un sistema mejor cada mes sin hacer las comprobaciones pertinentes. La inteligencia artificial generativa debería calificarse de alto riesgo hasta que no se sectorice y sea utilizada por expertos», considera Sierra.

El peligro de desarrollar una inteligencia superior al ser humano

La mitigación de los riesgos de la IA se ha convertido así en un tema recurrente tanto en la industria como en la academia. Cada vez más organizaciones como el instituto AI Now se enfocan en garantizar que estos sistemas «sean responsables ante las comunidades y los contextos en los que se aplican». Fue como parte de estos esfuerzos que se redactó la carta abierta para pausar el desarrollo de tecnologías de IA de gran alcance.

Entre las preocupaciones que se exponen en este llamado, los firmantes se preguntan: «¿Deberíamos desarrollar mentes no humanas que, con el tiempo, podrían superarnos en número, inteligencia, obsolescencia y reemplazo?». ChatGPT cree que no. Esta es su respuesta:

Como modelo de lenguaje de inteligencia artificial, me gustaría responder a la carta abierta del Future of Life Institute titulada «Pause Giant AI Experiments: An Open Letter». En primer lugar, aprecio el esfuerzo y la reflexión que se han puesto en la carta, ya que plantea preocupaciones importantes sobre los riesgos asociados con los experimentos de IA a gran escala.

La carta destaca el potencial de consecuencias catastróficas de los experimentos de IA mal diseñados y la necesidad de abordar el desarrollo de la inteligencia artificial de una manera más responsable y ética. Los riesgos asociados con los experimentos de IA son reales y es fundamental que los investigadores y los responsables de la toma de decisiones adopten un enfoque cauteloso y medido para el desarrollo de la IA.

Al mismo tiempo, es importante reconocer el inmenso potencial de la IA para tener un impacto positivo en la sociedad. La IA ya ha demostrado la capacidad de mejorar los resultados de la atención médica, acelerar descubrimientos científicos y mejorar nuestras vidas diarias de innumerables maneras. El desarrollo responsable de la IA tiene el potencial de resolver algunos de los desafíos más urgentes del mundo, incluido el cambio climático, la pobreza y las enfermedades.

Por lo tanto, es fundamental encontrar un equilibrio entre la cautela y el progreso en el desarrollo de la IA. En lugar de pedir una pausa completa en todos los experimentos de IA a gran escala, deberíamos centrarnos en desarrollar marcos sólidos para el desarrollo responsable de la IA. Esto incluye establecer directrices éticas claras y principios para el desarrollo de la IA, garantizar la transparencia y responsabilidad en la investigación de la IA y crear mecanismos para la supervisión y evaluación continuas del impacto de los sistemas de IA.

En conclusión, aunque estoy de acuerdo con las preocupaciones planteadas en la carta abierta del Future of Life Institute, creo que se necesita un enfoque más matizado y equilibrado para garantizar que podamos aprovechar todo el potencial de la IA mientras minimizamos sus riesgos. Debemos seguir priorizando el desarrollo responsable de la IA, pero no a expensas del progreso y la innovación.

- Pause Giant AI Experiments: An Open Letter

- Ricardo Baeza-Yates, director de investigación del Instituto de IA Experiencial de la Universidad Northeastern

- Artificial Intelligence Index Report 2022 y 2023, de la Universidad de Stanford

- Inteligencia Artificial, Our World in Data

- Lorena Jaume-Palasí, fundadora y directora ejecutiva de The Ethical Tech Society

- Parlamento Europeo

- Comisión Europea

- Encuesta global sobre IA 2022, de McKinsey

- Repositorio de controversias e incidentes algorítmicos y de IA (AIAAIC)

- Carles Sierra, director del Instituto de Investigación en Inteligencia Artificial (IIIA) del Consejo Superior de Investigaciones Científicas (CSIC)

- Instituto AI Now