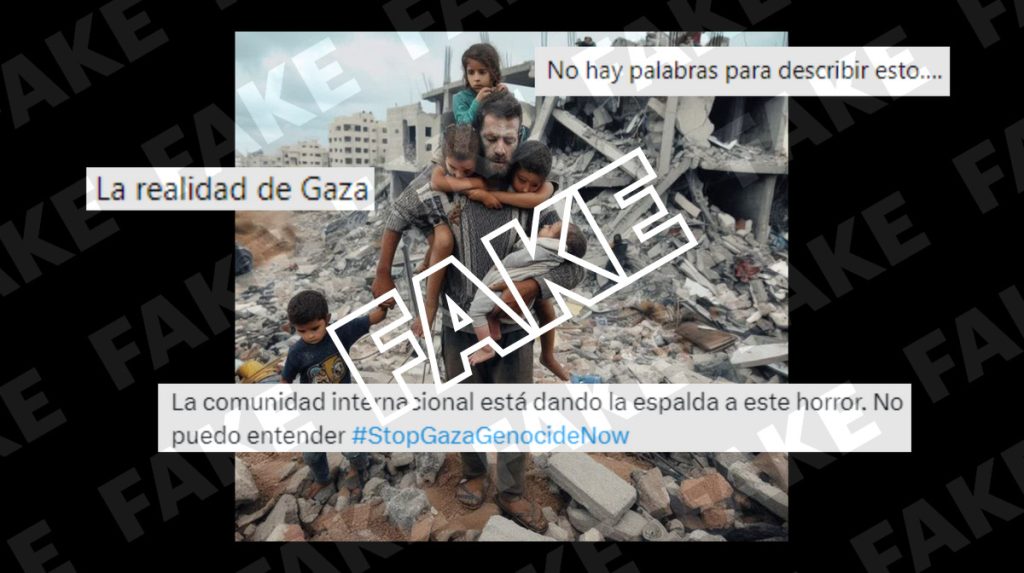

Circula por redes sociales una foto en la que se aprecia a un hombre rescatando a cinco niños de unos escombros, y que algunos usuarios han compartido asegurando que está tomada en Gaza. Sin embargo, es una foto generada con inteligencia artificial.

En la fotografía aparece un hombre en el centro de la imagen portando a varios niños: tres de ellos sobre su espalda, otro sobre un brazo, y a otro menor lo lleva de la mano. A su alrededor se muestran los escombros de un edificio. Los mensajes que han compartido esta imagen en plataformas como X –antes Twitter– y Facebook aseguran que es “la realidad de Gaza”. “No hay palabras para describir esto…” o “La comunidad internacional está dando la espalda a este horror. No lo puedo entender”, dicen otras personas.

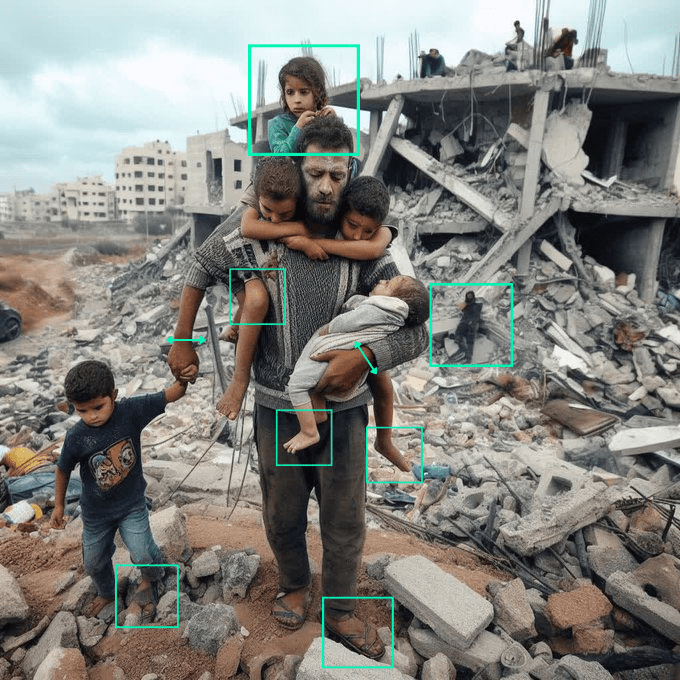

Pero la imagen contiene varios elementos que permiten deducir que se trata de una imagen creada con IA, como la falta de detalles en las manos y los pies. Verificadores miembros de la red internacional IFCN al igual que Newtral.es han llegado a las mismas conclusiones, como es el caso de la sección ‘Fake Off’ del medio 20 minutes (Francia).

La foto de un hombre rescatando a unos niños no es de Gaza

Desde Newtral.es hemos hecho una búsqueda inversa en Google con la foto del hombre portando a los niños, para ver si ha sido publicada por algún organismo oficial o medio de comunicación apuntando que fue tomada en Gaza, pero no hemos obtenido ningún resultado.

Con un análisis visual de la foto es posible detectar varios aspectos que permiten probar que es una imagen generada con inteligencia artificial. Uno de los elementos más importantes es la falta de detalles en extremidades, especialmente en pies y manos. Por ejemplo, los pies del niño de la izquierda son diferentes, y uno se acaba difuminando con el suelo. También, el menor que está en brazos del hombre posee un pie con tres dedos. En cuanto a los tres niños de detrás, no es posible distinguir cuáles son sus piernas, y de hecho, a la menor que se apoya en la cabeza del hombre no se le ven las piernas. También hay una persona junto a los escombros del edificio a la que no se le distinguen los brazos.

Otro elemento a destacar son las proporciones. Como ejemplo se pueden apreciar los brazos del hombre, puesto que uno es más grueso que otro, o un pie es más grande que el otro, además de tener una forma diferente.

Además, para verificar esta instantánea hemos utilizado herramientas de detección de imágenes creadas con inteligencia artificial. Estas aplicaciones no pueden ser la única fuente para verificar una foto de este tipo porque pueden cometer errores, pero sí pueden servir como una pista o indicio ante una posible imagen creada con IA. En este caso hemos usado AI or Not, que dice que “probablemente sea IA”, y Hive Moderation, que da una probabilidad del 99,9% de que la foto haya sido generada por IA.

El fotoperiodista Javier Bauluz, ganador del premio Pulitzer en 1995, compartió la misma foto en redes sociales como si fuera real y un hombre estuviera rescatando a unos niños en Gaza, pero después aclaró en su cuenta de X que había cometido un error ya que se trata de una fotografía “hecha con IA”.

[Cómo detectar imágenes, vídeos o audios generados con IA]

Otros bulos de imágenes generadas con inteligencia artificial

El desarrollo de la inteligencia artificial ha propiciado la difusión de contenidos falsos creados con este tipo de herramientas. En Newtral.es ya hemos desmentido varios de estos deepfakes, especialmente en formato de imagen, al igual que la foto del hombre supuestamente rescatando a unos niños en Gaza.

Por ejemplo, coincidiendo con la investigación llevada a cabo por la fiscalía de Manhattan sobre los supuestos sobornos de Donald Trump a la actriz porno Stormy Daniels, circularon distintas fotografías con las que se quería probar que el expresidente había sido detenido. Pero como aclaramos en Newtral.es, no eran ciertas. El autor de las fotos reconoció que las habría creado con la herramienta Midjourney.

Asimismo, recientemente se ha viralizado una imagen en la que aparecen aficionados del Atlético de Madrid en la grada de un estadio de fútbol desplegando una bandera gigante de Palestina. Pero también ha sido generada con IA, como hemos podido comprobar con varios elementos de la foto.