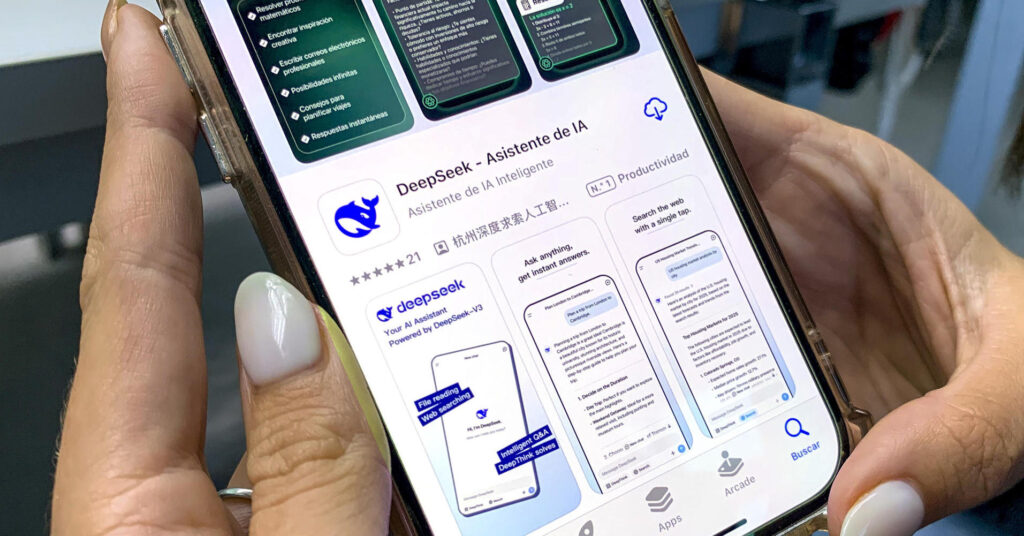

Una joven empresa china ha sacudido los cimientos del mercado de la inteligencia artificial. DeepSeek, conocido como el ChatGPT asiático, ha desplomado la cotización de gigantes como el fabricante de chips Nvidia. Pero también ha agitado a la comunidad científica y técnica tras presentar sus últimos modelos de razonamiento DeepSeek R1 y R1-Zero. La versión anterior, llamada V3, apenas data del pasado diciembre.

Quienes están familiarizados con el sector coinciden en que los datos presentados por DeepSeek (aunque no revisados por pares), de ser tal cual, demostrarían tres cosas:

- Coste. Relativiza la creencia de que desarrollar y poner en servicio grandes modelos de lenguaje (como el de ChatGPT) es muy costoso, tanto a nivel económico como energético.

- Tamaño empresarial. Ya no es cierto que sólo megacorporaciones como OpenAI (asociada a Microsoft), Meta o Alphabet (Google) tengan capacidad para desplegarlos y que deben proteger celosamente su creación bajo llave. DeepSeek es una startup con un producto nacido de las restricciones para importar chips de Nvidia. No hacía falta tanto hardware ni energía.

- Funciona en tu máquina y en abierto. El código tras su funcionamiento se ha abierto a la comunidad. Otras empresas o investigadores pueden adaptarlo a sus necesidades y hacer sus particulares entrenamientos para usos específicos de la IA. Ahora sabemos cómo han enseñado a sus máquinas, cosa que nunca desvelaron del todo en OpenAI con GPT.

Matiza el doctor Deepak Padmanabhan (Queen’s University de Belfast): te lo puedes instalar en tu dispositivo y funciona sin internet. Pero “aún necesitarás tener acceso a grandes datos y una enorme potencia computacional, pero esto es, de todos modos, un gran paso adelante”.

En este sentido, Michael J. Davern, profesor de Contabilidad y Sistemas de Información de la Universidad de Melbourne (Australia), lo resume así: “Se puede hacer más con menos. También ha puesto en peligro la competitividad de los productos y desarrollos estadounidenses de inteligencia artificial que ya existen”. Los grandes modelos de lenguaje existentes son buenos prediciendo. DeepSeek R1 es bueno razonando, en un sentido no humano.

Junto a su colega Matt Pinnuck, analizan en profundidad el impacto en el mercado tecnológico de DeepSeek en The Conversation. Pero, más allá, ¿hasta qué punto es un hito a nivel científico en el campo de la IA?

De la necesidad, virtud: las restricciones para importar chips Nvidia agudizaron el ingenio

El doctor Ignacio Mártil (UCM), experto en física y microelectrónica, recuerda que el desarrollo de la IA necesita de grandes capacidades de procesamiento. Lo que hasta ahora conocíamos como tarjetas gráficas GPU (y sus chips) han resultado un hardware excelente para ello. Y el primer fabricante mundial es Nvidia.

EEUU, en guerra comercial con China, restringió las exportaciones de chips. Las empresas chinas han tenido que apañarse con un stock limitado, incluida DeepSeek, que usó apenas unos 2.000 del modelo H800 para su versión V3. El lanzamiento de R1 demuestra que no le ha sido necesario comprar grandes cantidades a Nvidia. Hay una arquitectura inteligente de hardware, pero sobre todo una manera ingeniosa de entrenar a su IA.

Fun fact. Mártil recuerda que Nvidia es una empresa estadounidense cotizada en el Nasdaq, sí. Pero fabrica sus chips en Taiwán. El mundo sigue dependiendo de las factorías asiáticas de semiconductores desde que en los años setenta se deslocalizó su producción, pese a ser un invento nacido en el Valle del Silicio californiano.

¿Cómo funciona el modelo de DeepSeek para plantar cara a ChatGPT?

La catedrática Belén Díaz Agudo (GAIA-UCM) destaca una frase clave en el preprint de presentación de R1 y R1 Zero: ”Pone de relieve el poder y la belleza del aprendizaje por refuerzo: en lugar de enseñarle explícitamente al modelo cómo resolver un problema, le proporcionamos los incentivos adecuados y él desarrolla de manera autónoma estrategias avanzadas de resolución de problemas”.

| Aprendizaje por refuerzo: Razonar paso a paso. Explica la catedrática que es parecido a lo que se usa en comportamiento en videojuegos. Algo así como que la máquina descompone el problema, toma una parte, busca datos, hace un cálculo, sigue con otra parte, etc. “Es lo que le ha permitido aprender a razonar con poca intervención humana (sobre todo R1 Zero), sólo mediante recompensas o refuerzos”, señala a Newtral. es. En el entrenamiento, no sólo miden el grado de error en la respuesta, sino que cuando más precisa y exacta es, más se incentiva a la máquina. Este método se llama Cold Start Data. | |

| Arranque en frío, Cold Start: Al principio empiezan con el modelo en blanco y lo entrenan con unos pocos ejemplos etiquetados por expertos, sintetiza desde el VRAIN-UPV el catedrático Carlos Montserrat. ”Con esos pocos ejemplos, el modelo puede hacerse una idea de qué va lo que tiene que aprender”. Pero hay algo por encima que finaliza el entrenamiento. Y no es humano. Aquí es donde hablamos de expertos. | |

| Mezcla de expertos (MoE): Esto no es tan nuevo y no tiene que ver con expertos humanos. Se llama así a dividir la tarea en múltiples subredes específicas más pequeñas (los expertos) que se entrenan en algo concreto. “Luego, al detectar el prompt (la consulta que se le hace), hay un módulo que lo deriva al experto que corresponde”. No es exclusivo de DeepSeek, pero es escalable (no tienes que cambiar todo el modelo) y aportan un desarrollo muy eficiente gracias a algo conocido como destilación. | |

| Destilación: Una vez más, nada que ver con licores. “Se trata de entrenar modelos más pequeños y condensar el conocimiento del grande“, señala Montserrat. Todo ello hace algo mejor en lo que flojea GPT: |

DeepSeek es menos cuñado que ChatGPT. Quizás es más lento, va paso a paso razonando y, desde luego, puede perderse por el camino. Pero “es capaz de decir no lo sé”, apunta el profesor.

Publicidad

- Prepublicación del equipo de DeepSeek en ArcXiv, 2025

- Belén Díaz Agudo (GAIA-UCM)

- Carlos Montserrat (VRAIN-UPV)

- Ignacio Mártil (UCM)

- Deepak Padmanabhan (Queen’s University de Belfast)

- Liu Tongliang (Univ. Sídney, Australia)

- Michael J. Davern (Univ. Melbourne, Australia)

- Efe