“Yo, Kamala Harris, soy la candidata demócrata a la presidencia porque Joe Biden expuso por fin su vejez en el debate. ¡Gracias, Joe!”, dice la voz de Harris en un vídeo que imita la estética de sus anuncios electorales. “Si crees que el país se ha ido a la mierda durante los últimos cuatro años, todavía no has visto nada”, sentencia mientras el vídeo muestra el logo oficial de su campaña.

El vídeo fue publicado el pasado julio por Elon Musk, dueño de la red social X, en dicha plataforma, y a finales de septiembre alcanzaba los 136 millones de reproducciones. ¿El problema? Aunque sea su voz, Kamala Harris no ha pronunciado ninguna de esas palabras y el video no forma parte de su campaña: se trata de desinformación en forma de deepfake, en este caso un montaje con audio sintético generado con inteligencia artificial (IA).

- Un método entre muchos. La clonación de voz es solo una de las técnicas posibles para difundir desinformación a a través de un deepfake. A pesar de lo convincente del resultado, este método es una de los más sencillos y accesibles, y requiere de una muestra muy pequeña de la voz que se pretende clonar: bastan unos 30 segundos de grabación para que la IA pueda imitar cómo suena cualquier persona.

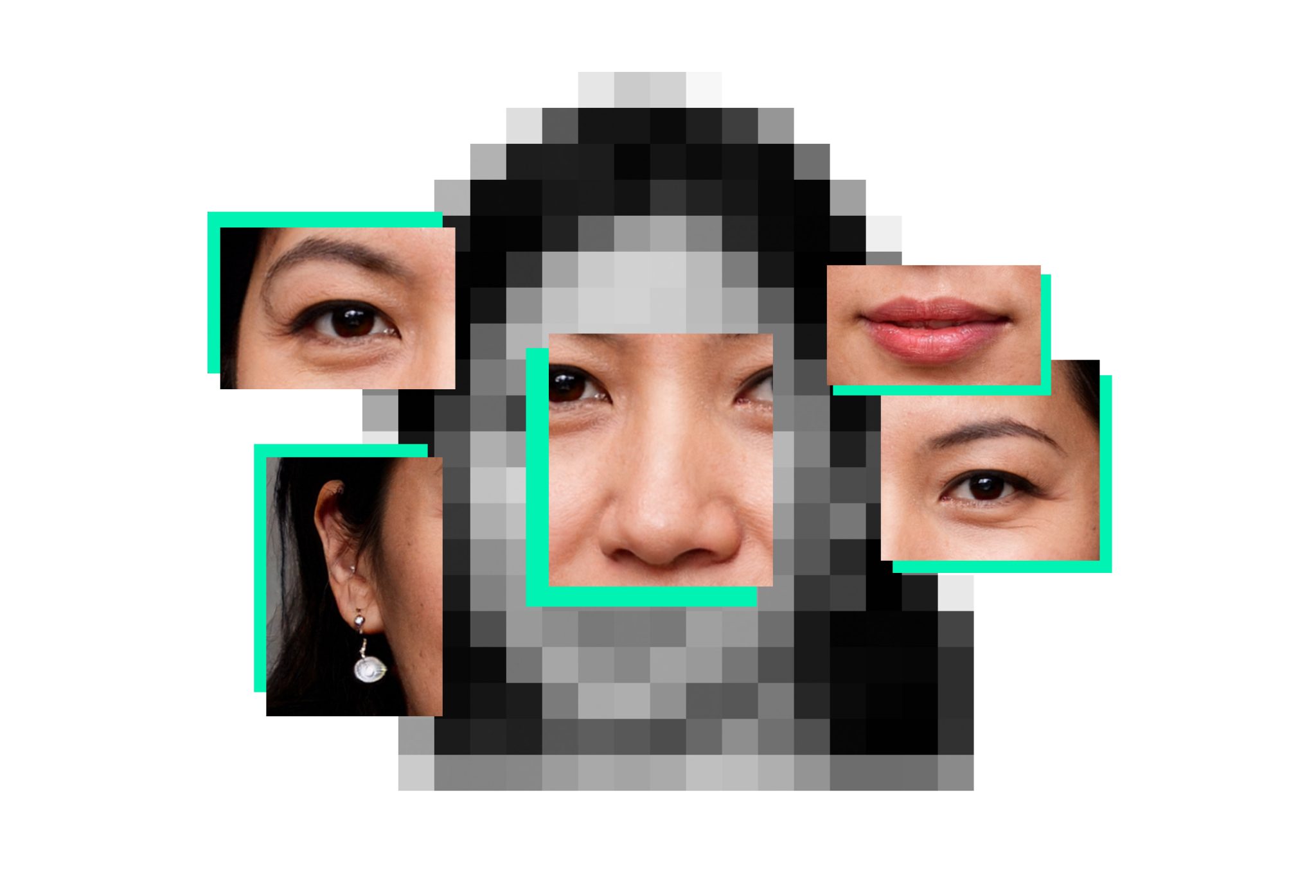

¿Qué es un deepfake? Según el Instituto de Ciberseguridad (INCIBE), un contenido falso, elaborado mediante inteligencia artificial, que pretende hacer creer a los espectadores que una determinada persona realizó declaraciones o acciones que realmente nunca ocurrieron.

A la manipulación de audio, como en el caso de Kamala Harris, se añade la de fotos y la de vídeos, haciendo que casi cualquier contenido digital pueda ser alterado o falsificado y muestre discursos o acciones que nunca han tenido lugar. Analizamos paso a paso cuáles son las técnicas de deepfakes más utilizadas para elaborar esta clase de desinformación, y qué herramientas se utilizan para detectarla: