Los deepfakes audiovisuales son una de las formas más sofisticadas de desinformación en internet. Aunque la tecnología existe desde hace años, evoluciona constantemente para lograr resultados más creíbles y difíciles de detectar. Estas son algunas de las principales técnicas para su elaboración.

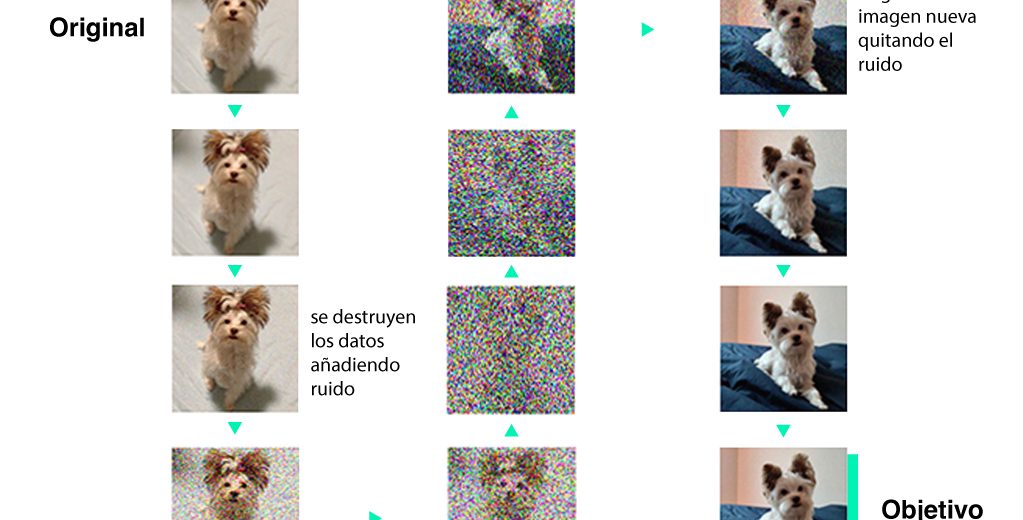

Redes de difusión: ensuciar una imagen para crear otra nueva

Las redes de difusión son la tecnología más puntera y moderna para elaborar deepfakes audiovisuales, como explica a Newtral.es Aruna Sankaranarayanan, investigadora en el laboratorio de IA del MIT (Massachusetts Institute of Technology, EE.UU). Según la experta, ver este tipo de contenido es poco común porque requiere mucho tiempo y esfuerzo, además de un hardware caro.

Según explica Sankaranarayanan, como los demás modelos, este requiere un conjunto de datos con el que entrenar al algoritmo. A estos datos se les añade “ruido”, haciendo las imágenes irreconocibles. Después, el modelo realiza el proceso contrario, deshaciendo el ruido generado y volviendo a recrear la imagen original pero con los cambios deseados:

- Ruido. La imagen se distorsiona poco a poco, añadiendo patrones aleatorios y manchas hasta que se vuelve casi irreconocible.

- Entrenamiento. El modelo de difusión se entrena para tomar esa imagen distorsionada y ruidosa, y «limpiarla», restaurándola a su estado original y nítido.

- Generación. Cuando se quiere crear una imagen nueva no se parte de la foto original, sino de la distorsionada. El modelo entrenado transforma ese ruido, puesto que ya ha aprendido a recuperar la información que había dentro de él, hasta que aparece una nueva imagen que no coincide con la original pero tiene datos similares.

Ojo, la tecnología más puntera, pero no por mucho tiempo. Según OpenAI, plataforma que desarrolla el modelo Sora, que permite crear vídeos a partir de descripciones de texto, los resultados logrados por las redes de difusión pueden ser mejorados por los nuevos consistency models (modelos de consistencia). Estos nuevos modelos convierten directamente el ruido en datos y necesitan menos entrenamiento que las redes de difusión, saltándose el paso intermedio descrito más arriba.

Redes generativas antagónicas: el método de ensayo y error

Las redes de difusión han ido sustituyendo a su predecesoras, las redes generativas antagónicas (o GAN, generative adversarial network), el método más novedoso hasta hace dos años.

Según explican Javier Huertas y Helena Liz-López, investigadores de la Universidad Politécnica de Madrid, en esta técnica el trabajo se divide entre dos componentes: el generador, que crea el contenido falso, y el discriminador, que evalúa su autenticidad. Entre los dos componentes realizan una especie de entrenamiento en el que ambos pivotan las imágenes hasta que mejoran su rendimiento, haciendo que el deepfake sea cada vez más realista y difícil de detectar.

Lip-syncing: simple y peligrosamente eficaz

Sin embargo, como indica Sankaranarayanan, uno de los métodos más sencillo y frecuente para crear deepfakes audiovisuales consiste en el lip-syncing (sincronización de labios). Este sistema combina la clonación de voz con una técnica de edición de vídeos que hace que el movimiento de la boca de la persona suplantada coincida con el discurso que el falsificador decida ponerle.

- ¿Cómo de sencillo es crear este tipo de deepfakes? Desde Newtral.es hemos contactado a un creador de vídeos humorísticos, @habibi_TV_ en Tik Tok, elaborados con esta técnica. El usuario aclara que, en su caso, los videos se crean mediante dos aplicaciones de teléfono móvil y “en menos de 10 minutos”.

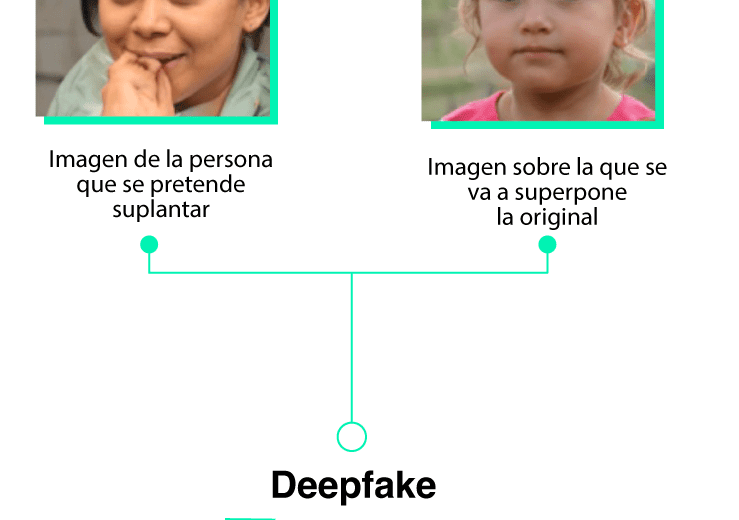

Face-swapping: cómo la IA copia y pega una cara

El uso del audio sintético con el lip-syncing es suficiente cuando existen imágenes de la persona a suplantar y solo se quiere añadir un discurso específico sobre ellas. Pero cuando las imágenes que se van a utilizar corresponden a otra persona, es necesario superponer sobre ellas la cara de la persona a la que se va a suplantar.

A esta técnica se le conoce como face-swapping, cambio de caras en inglés, y la combinación de face-swapping y lip-syncing es, según Sankaranarayanan, el sistema más popular y extendido para elaborar los deepfakes audiovisuales que proliferan en redes sociales.

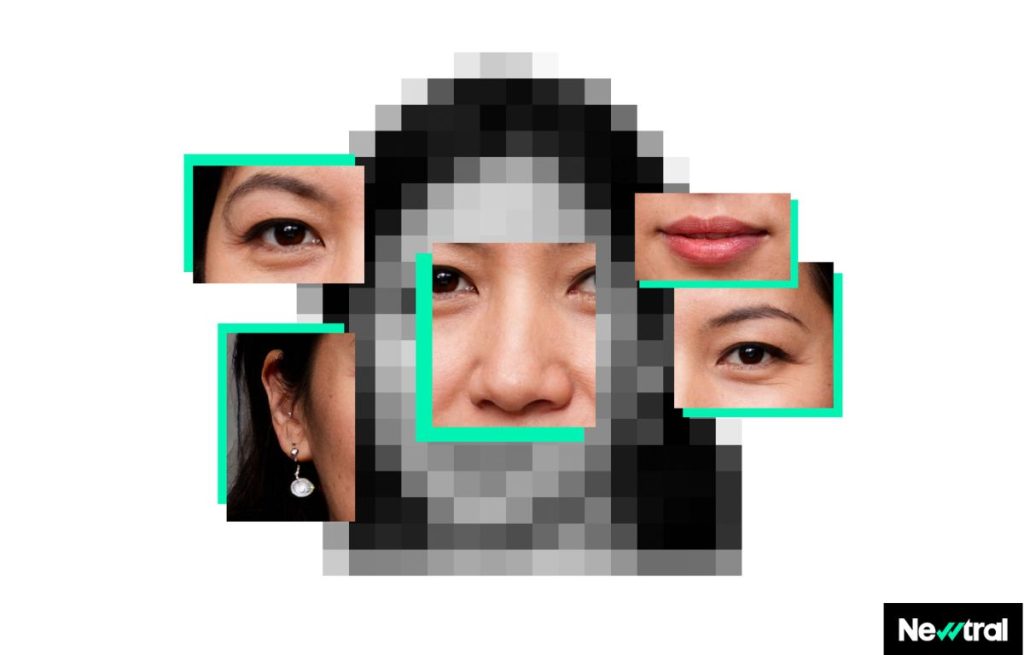

Al igual que con las demás técnicas, los modelos de face-swapping necesitan datos de entrenamiento, es decir, imágenes de muestra de la persona suplantada. Cuanto más datos tenga el algoritmo y más variados sean (diferentes ángulos, expresiones faciales y grados de iluminación), más creíble será el deepfake.

- ¿Cuántas imágenes necesita un modelo para entrenar? Depende de su complejidad y del resultado que se busque. El Museo de Dalí en San Petesburgo (Florida) da la bienvenida a sus visitantes con un deepfake del pintor que entrenó con más de 6.000 reales imágenes del artista. En cambio, existen aplicaciones móviles que pueden realizar el cambio de cara con una sola imagen de referencia, aunque con peores resultados.

Como explica Sankaranarayanan, el peligro de este método es la facilidad de uso que puede ofrecer. Mediante aplicaciones de uso comercial, casi cualquier usuario puede elaborar deepfakes audiovisuales sin necesidad de tener un equipo especializado.

Aunque los resultados son menos convincentes que los que se logran mediante técnicas avanzadas, el bajo coste de producción, tanto en tiempo como en dinero, hace que puedan producirse en alto volumen y por una gran variedad de usuarios, cuyas intenciones pueden ir desde el humor y el entretenimiento hasta la desinformación electoral o bélica.

- Deep Tom Cruise: cuando el parecido es anterior al deepfake. En el caso de que no se utilice como base un vídeo o imagen existente, sino que se grabe uno nuevo especialmente con el propósito de superponer una cara nueva sobre la original, el proceso es más sencillo. Sankaranarayanan explica que este fue el caso de los deepfakes de Tom Cruise, muy virales hace dos años, en los que el actor original tiene un gran parecido físico con el suplantado.

Con ilustraciones de Sandra Vilches y animaciones de Ignacio Arasanz.

- Aruna Sankaranarayanan, investigadora en el laboratorio de IA del Massachusetts Institute of Technology

- Javier Huertas y Helena Liz-López, investigadores en el grupo AIDA (Applied Intelligence and Data Analysis Group) de la Universidad Politécnica de Madrid.

- Generation and detection of manipulated multimodal audiovisual content: Advances, trends and open challenges. H. Liz-López et al. 2024

- Diffusion Models: A Comprehensive Survey of Methods and Applications. L. Yang et al. 2022

- Consistency Models. Y. Song et al. 2024

- OpenAI

- TikTok

Gracias por vuestro trabajo tan pedagógico y necesario.

Magnífico reportaje. ¡Enhorabuena!