Los algoritmos diseñados para crear deepfakes requieren un entrenamiento previo para que el modelo aprenda a reproducir la voz, el aspecto o las expresiones faciales de la persona a la que buscan suplantar. En el caso de los deepfakes de audio, el entrenamiento requerido es muy reducido, y no es necesario que existan en internet tanto metraje de la víctima, como en el caso de los vídeos.

Con 30 segundos de grabación puede ser suficiente para replicar mediante IA la voz de una persona, según explican a Newtral.es Javier Huertas y Helena Liz, investigadores en el grupo AIDA (Applied Intelligence and Data Analysis Group) de la Universidad Politécnica de Madrid.

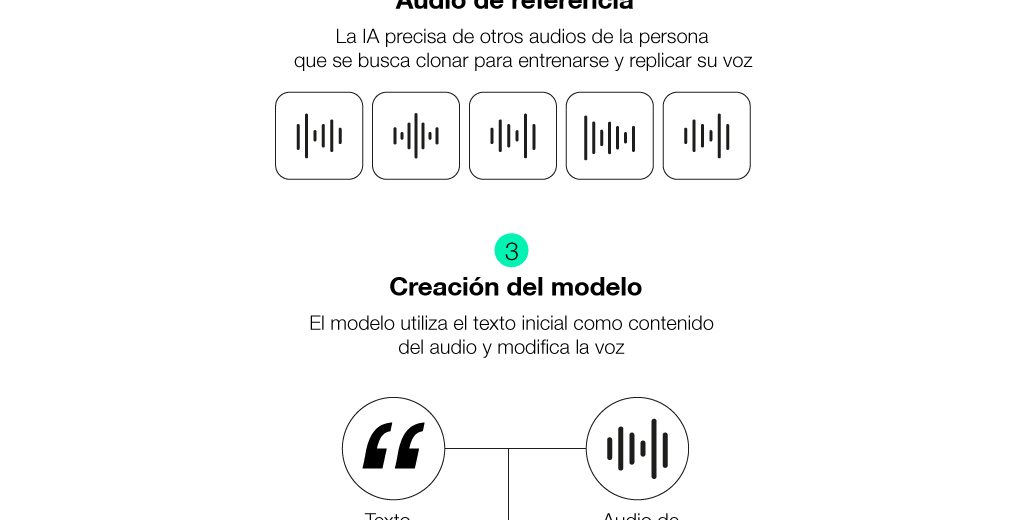

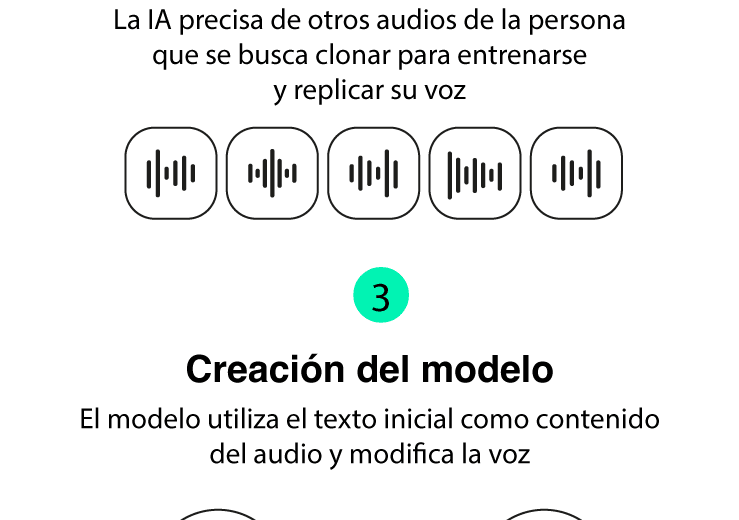

- Cómo se clona una voz. El proceso de clonación comienza con un entrenamiento. El algoritmo emplea muestras reales de la voz que se pretende clonar para aprender sobre su entonación, sus inflexiones y su timbre, entre otros elementos. Aunque una muestra reducida puede ser suficiente para producir resultados creíbles, cuanto más amplio sea el repertorio, más parecida será la voz clonada a la real.

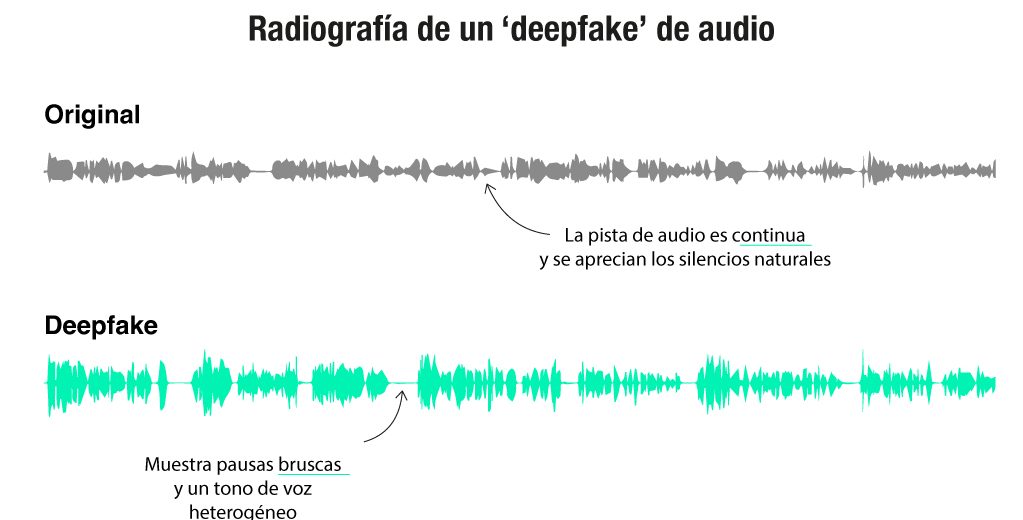

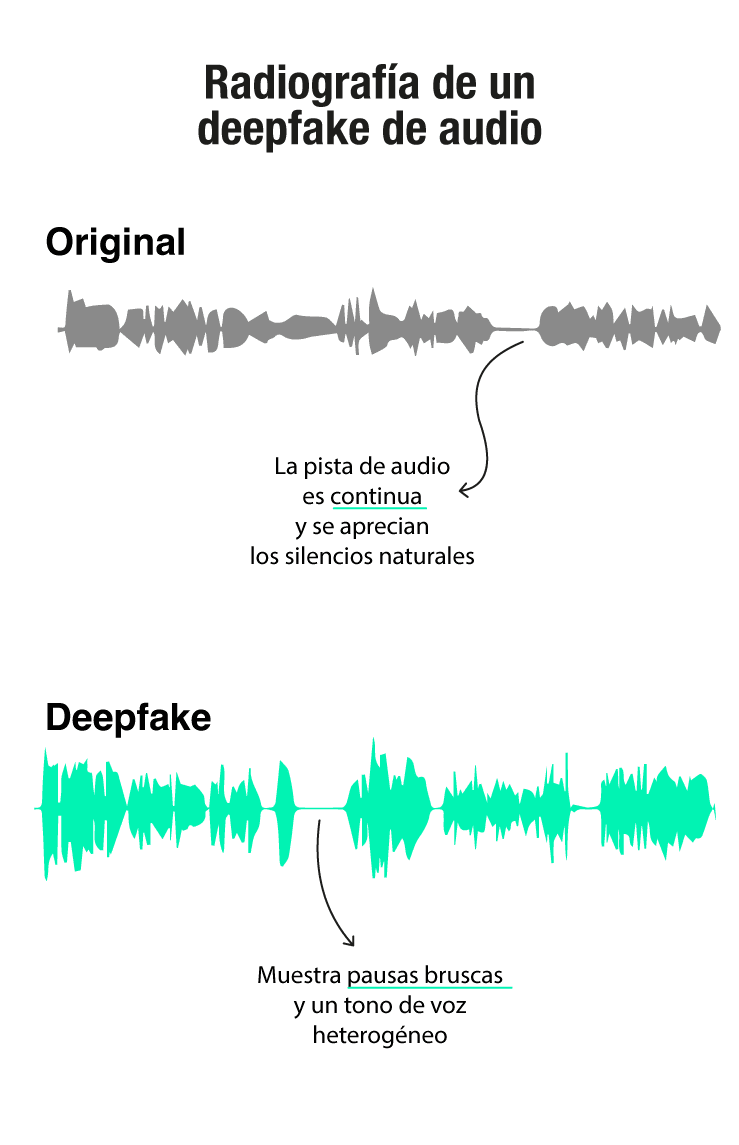

- Qué dice una onda de audio sobre su autenticidad. Cuando los métodos no son muy profesionales, analizar visualmente la forma de onda en la pista de audio del deepfake puede dar alguna pista sobre su origen artificial.

En este ejemplo, vemos dos vídeos de una intervención de la ministra de Sanidad, Mónica García, con sus respectivas ondas de audio. La primera nota de audio se trata de un discurso real de García durante una rueda de prensa el pasado 30 de julio, después de un Consejo de Ministros. El segundo utiliza las mismas imágenes, pero se trata de un deepfake que ya verificamos en Newtral.es.

En la pista original, el audio es continuo, exceptuando los silencios naturales entre frases. En el deepfake, la onda está entrecortada, puesto que no corresponde a un audio real, sino que ha sido elaborado con fragmentos creados artificialmente.

- ¿Cuáles son los riesgos de estos deepfakes? Además del riesgo de desinformación política, como este vídeo de Biden verificado por Newtral.es, existe también el riesgo de las estafas mediante el uso de voces clonadas que, por ejemplo, imiten al CEO de una empresa y ordenen a los empleados realizar una transferencia, como ocurrió el pasado enero, según informó el INCIBE.

Con animaciones de Ignacio Arasanz.

- Javier Huertas y Helena Liz-López, investigadores en el grupo AIDA (Applied Intelligence and Data Analysis Group) de la Universidad Politécnica de Madrid. Generation and detection of manipulated multimodal audiovisual content: Advances, trends and open challenges. H. Liz-López et al. 2024

- Generation and detection of manipulated multimodal audiovisual content: Advances, trends and open challenges. H. Liz-López et al. 2024

- Instituto de Ciberseguridad (INCIBE)