La próxima vez que cuentes los dedos de las personas en una imagen creada por inteligencia artificial puede que detectes el engaño. Pero la siguiente, lo más probable es que ya no funcione. ¿Cómo detectar medios sintéticos, es decir, distinguir imágenes, vídeos o audios generados por una IA de los reales, cuando la tecnología avanza tan rápidamente?

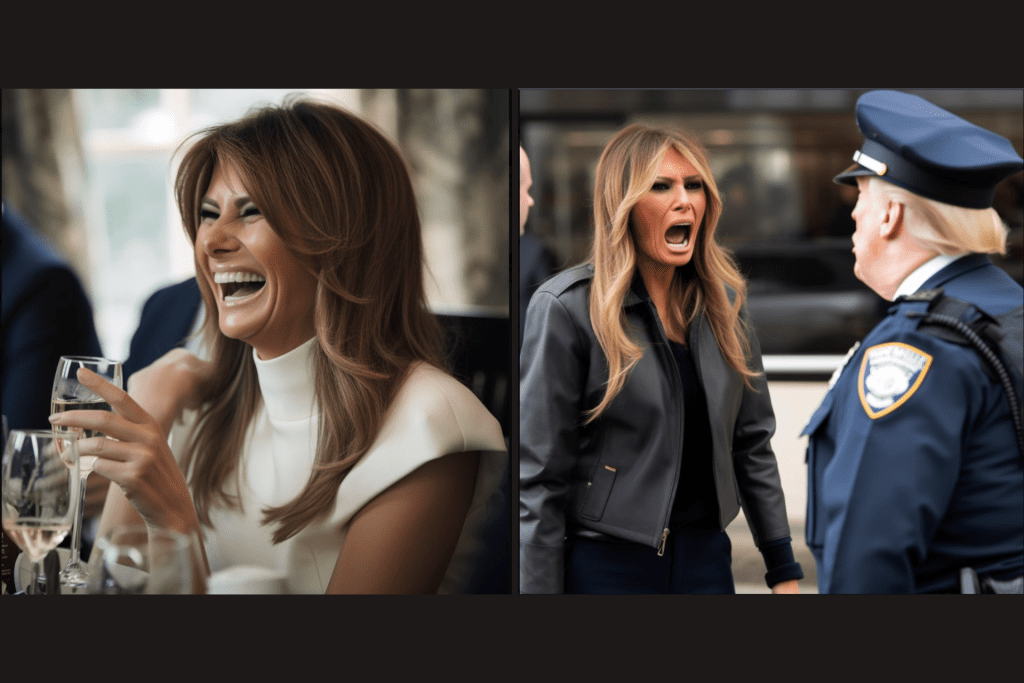

Los ejemplos sobran: en la última semana hemos visto una imagen del Papa con una parka similar a un modelo de Balenciaga, y poco antes de eso, una serie de 50 fotos en las que Donald Trump está siendo arrestado. Ambas son deepfakes. Un meme humorístico en el primer caso y una creación de uno de los fundadores de Bellingcat, en el otro, que fue creado para concienciar acerca de la capacidad de impacto de las imágenes generadas con IA en un momento determinado: esto sucedió apenas unos días antes de que la justicia presentase cargos penales contra Trump por presuntamente comprar el silencio de una actriz porno.

Sólo la primera de las imágenes del hilo en este momento tiene más de 6,1 millones de reproducciones, y varias organizaciones de verificadores recibieron consultas de personas sobre la veracidad de las fotos, Newtral entre ellas.

Lo que más preocupa son los usos malintencionados con los que pueden ser cargadas estas herramientas. A poco más de un mes de comenzar la guerra en Ucrania, aparecía un deepfake de Zelenski, y el año pasado, un impostor que se hacía pasar por el alcalde Kiev mantuvo conversaciones con cinco de sus homólogos europeos en videoconferencia -el de Madrid entre ellos- ante la sospecha de deepfakes en tiempo real.

Recientemente, el gobierno golpista militar en Birmania impuso cargos de corrupción a un detenido político basándose en declaraciones de un funcionario en un vídeo que muchos sospechan que puede ser un deepfake.

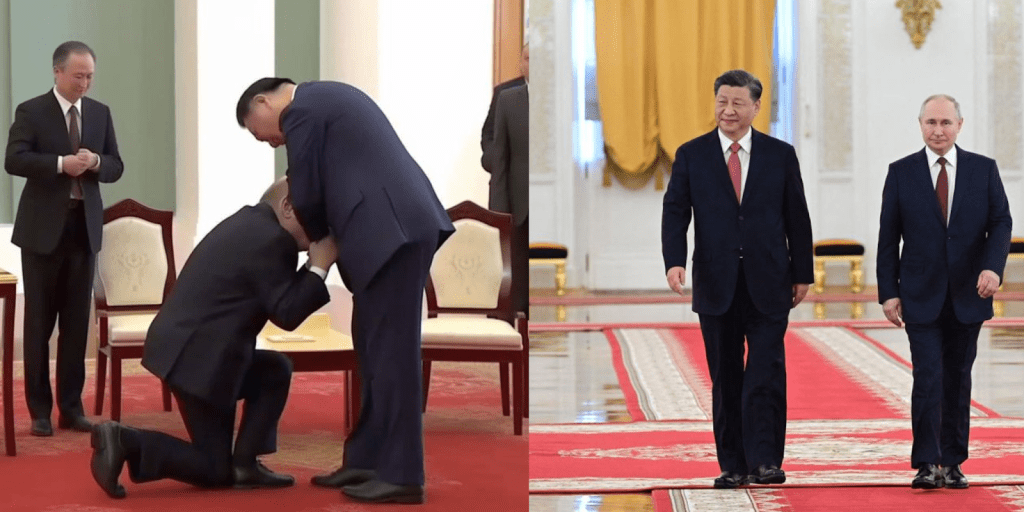

Un poco más cerca, una supuesta imagen de Vladímir Putin arrodillado ante el presidente chino, Xi Jinping, apareció tras la propuesta china de un plan de paz para Ucrania. Varios verificadores, entre los que se encuentra Newtral.es, comprobaron que la imagen había sido generada con IA. Imágenes tomadas en el encuentro real muestran que sólo se dieron la mano.

Hacia un mundo donde no distinguimos la ficción de la realidad

“Necesitamos estar alerta ante lo que confiamos en internet. Puede sonar simple, pero cómo avancemos en la era de la información marcará la diferencia entre que sobrevivamos o nos transformemos en una jodida distopía. Gracias, y manteneros despiertos, putas”. Esto que dijo un deepfake de Barack Obama creado por Jordan Peele, guionista estadounidense en 2018, sigue vigente, tacos aparte. El deepfake de Obama fue el primer producto de medios sintéticos o synthetic media, como se llama a los vídeos, imágenes o audios creados por IA, con capacidad para que nos preguntáramos si la IA ya estaba creando materiales indistinguibles de la realidad.

Al verlo cuatro años después, nos damos cuenta enseguida de que algo raro pasa con la boca de ese Obama, pero tenemos otros deepfakes que nos hacen dudar.

El estado de las IA generativas evoluciona hacia un mundo en el que es cada vez más difícil detectar imágenes o vídeos generados por la IA a simple vista y que, a largo plazo, abona el terreno para la desconfianza general hacia todo tipo de imágenes, incluso las reales.

En casos como el de Birmania, en el que usuarios de redes sociales y periodistas cuestionaron la veracidad del vídeo, los periodistas birmanos no tenían forma de comprobar la autenticidad del material, lo que ha puesto de manifiesto la necesidad de que las herramientas y destrezas de la verificación lleguen a todos los profesionales de la información y no sólo a los de grandes corporaciones que puedan pagarlas.

Imágenes y vídeos generados con IA: tecnología vs. espíritu crítico

Los detalles visuales de los deepfakes que ayer nos podían indicar su falsedad no nos valen para hoy, y probablemente los que distinguimos hoy no nos valdrán para mañana.

Una de las formas de detectar imágenes, vídeos y audios generados con IA es a través de la tecnología: si se usa para crearlos, también puede servir para detectarlos. Ya en 2018 las conclusiones de un grupo de 30 expertos en IA, periodistas e investigadores en derechos humanos, reunidos por First Draft y WITNESS, reconocía que los humanos no son buenos detectando la diferencia entre un vídeo real y uno falso, pero las máquinas sí.

El mismo informe dice que no hubo consenso entre los expertos sobre quiénes ganarán la carrera entre productores y detectores de deepfakes, pero en todo caso la tecnología enfocada a la detección debería seguir evolucionando.

Sam Gregory es un experto en desinformación y defensor de los derechos humanos que ha trabajado durante años en proyectos de tecnología, medios y participación ciudadana. Es director de WITNESS, organización que ha puesto un grupo de expertos en deepfakes a disposición de verificadores en todo el mundo. Gregory no recomienda el uso de herramientas en línea al público general para detectar imágenes, vídeos y audios generado por IA, ya que la mayoría de esos detectores no funcionan bien, están enfocados a determinados contenidos –los fiables suelen serlo específicamente contra el material con el que fueron entrenadas, pero no con otros– y pueden crear falsos positivos y negativos.

«Siempre deberías dar un paso atrás y pensar qué quiere provocar en ti alguien con esa pieza de contenido» (Sam Gregory)

Cree que es mejor enfocarse en la alfabetización no sólo digital y mediática, sino también en IA para que más medios y periodistas tengan acceso a herramientas y que más personas puedan formar espíritu crítico en torno a las imágenes y otros productos generados por IA.

Lo primero que hay que hacer cuando nos encontramos con la sospecha de estar ante un deepfake, según Gregory, es “detenerse, investigar la fuente, buscar cobertura alternativa y rastrear el original antes de dejar que las emociones o nuestras primeras impresiones nos guíen”.

El contexto: clave para detectar contenido falso

El estado actual de la IA generativa hace que aún haya problemas con una serie de detalles en las imágenes generadas por IA, lo que suele proponerse como forma de detectar a la máquina detrás de esos productos. Pero no deberíamos fiarnos.

Todos los expertos consultados por Newtral han sido cautos al recomendar detalles visuales a observar, y siempre agregan la prevención “por ahora”, conscientes de que estos sistemas mejoran continuamente y tienen como objetivo lograr un aspecto más real. Las imágenes de Trump arrestado fueron creadas por la versión anterior de Midjourney, la nueva que ha salido el 16 de marzo ya ha mejorado la calidad de las manos.

¿Qué debemos tener en cuenta entonces? Siempre el contexto. “Siempre deberías dar un paso atrás y pensar qué quiere provocar en ti alguien con esa pieza de contenido, si está intentando incitar una emoción particular, curiosidad, ira o solidaridad”, dice Gregory, que recomienda no compartir o retuitear el mensaje cuando este contexto no esté claro.

Algunas de las prácticas de la alfabetización mediática que indica son las que los verificadores llevamos a cabo constantemente: buscar el autor de la imagen, ver si hay otras versiones o perspectivas sobre el asunto, buscar información de la escena y la situación.

Checklist de detalles para descubrir deepfakes (por ahora)

Los creadores de deepfakes son quienes mejor saben qué falta por mejorar y, por lo tanto, qué pistas nos pueden indicar que hay IA detrás de un vídeo, imagen o audio. Hemos hablado con Alejandro Pérez Blanco, creador de deepfakes de vídeo que trabaja en El Intermedio; con Ramon Arteman, director de Metropolitana, el estudio que creó las imágenes para el vídeo de Lola Flores, y con Aitor Álvarez, ingeniero responsable en tecnologías del habla de IA en Vicomtech, para hacer una lista de detalles donde mirar, al menos mientras sea posible:

Luces y sombras

Las IA generativas tienen algunos problemas para ubicar bien las sombras en una imagen, por lo que el análisis forense manual hace comprobaciones de perspectivas geométricas, iluminado, sombras y la “física” de las imágenes.

Reflejos de los ojos en los deepfakes

El ojo es como un cristal, y a veces el reflejo no se corresponde con el entorno. “Las miradas sí las controlamos”, dice Arteman, “porque recortamos el ojo, pero poner el reflejo es mucho trabajo para lo poco rentable que es”. Es uno de los puntos débiles del deepfake actual, especifica, porque no está seguro de que en un tiempo esto se haga bien.

Manos, dientes, orejas, articulaciones

Actualmente (con mucho énfasis en la temporalidad, porque las IA van evolucionando muy rápidamente), en estos detalles suele ser más fácil identificar a una imagen hecha con IA. Los dientes son demasiados, muy pocos, o difusos. Las manos son irreales, con dedos de más o de menos, o distorsionadas. Pudo verse en el ejemplo de las imágenes de Trump detenido, y también en las manos de la figura de fondo del falso Putin arrodillado ante Xi Jinping (1).

Las máquinas se encuentran con dificultades también para representar las articulaciones de las personas en las imágenes generadas por IA, como se puede ver en las piernas de Putin en esta última. Otros detalles: vemos que la oreja de Putin tiene unos pliegues extraños (3), mientras que la cara de Jinping está distorsionada y difusa y la cabeza tiene una forma extraña (2). También podemos notar una caída poco natural del pantalón de Jinping (4).

Los saltos raros de calidad y nitidez en los vídeos son una de las principales pistas que hacen sospechar a Pérez Blanco, “sobre todo cuando hay cambios en la cara, por ejemplo que los ojos sean muy nítidos pero en otra zona no”, como podemos ver en filtros tipo Snapchat.

Mala calidad

La primera alerta para Pérez Blanco es si el audio o el vídeo tiene mala calidad pudiendo tener una mejor realización, y lo ilustra con algo que sucede en una película de Police Academy, donde un policía hace sonidos como de un helicóptero de una forma bastante creíble, pero el sonido está roto. No podría hacerlo de forma creíble si la grabación hubiera sido de calidad superior. Lo mismo sucede con el vídeo de Phyo Min Thein, el preso político en el caso birmano, donde la mala calidad de la producción del primer vídeo que circuló hace que sus labios no vayan sincronizados con el audio, lo que reforzó las dudas sobre su veracidad.

Proporciones del cuerpo, piel, pelo, movimientos en los deepfakes

Un tipo de deepfakes de personas se hace encajando los cambios en el rostro, pero usando un actor para el cuerpo. “Cuando hacemos un deepfake nosotros sólo cambiamos el rostro. La morfología, el cuello, la piel, el pelo, incluso cómo se mueve, son detalles que tienen que ser coincidentes”, explica Arteman. En estos casos se puede observar, tanto en vídeos como en imágenes generadas por IA, si hay proporciones extrañas en torno a cuello, ojos, hombros, problemas en el tono de la piel; o revisar los movimientos si es un vídeo.

Fondos, entorno y una realización simplificada

Los fondos en las imágenes generadas por IA suelen tener muy pocos detalles o estar difuminados. A veces allí hay elementos distorsionados o personajes extraños que pueden dar una pista.

En algunas producciones, la realización es una señal. “Si veo que todo es demasiado frontal, la luz es muy plana, la cabeza no gira demasiado, no pasa nada por detrás y las manos no pasan por delante de la cara, pienso que yo lo hubiera hecho así para facilitarme la tarea lo más posible”, dice Pérez Blanco.

Otros detalles que suelen tener las imágenes generadas con IA son:

Demasiada regularidad en lo que debería ser irregular: rostros sin imperfecciones, o gotas distribuidas a la misma distancia en una superficie que muestra gotas de lluvia, por ejemplo.

Expresiones faciales exageradas: cuando uno le pide a la IA que genere rostros con alguna emoción, suele exagerarla. Un ejemplo son las de Melania Trump en la serie de imágenes sobre Trump arrestado.

Textos ilegibles: en los fondos, en los carteles o donde pueda aparecer texto, este suele ser difuso, ilegible o con caracteres irreconocibles o inventados.

Más allá de las imágenes generadas por IA: ¿qué pasa con el audio sintético?

En los últimos años, los desarrollos de la IA se han extendido hacia el audio. En la actualidad la síntesis de voz y la conversión de voz son los enfoques tecnológicos más usados con IA y redes neuronales para hacer clonación de voz y deepfakes de audio. Álvarez, responsable del Grupo de Tecnologías del Habla en Vicomtech, trabaja con sistemas automatizados para detectar audios sintéticos, y cree que aunque cada vez es más complicado detectar si un contenido es falso o no, todavía quedan aspectos en los que un humano se puede fijar.

Si hablamos de audios sintéticos generados con tecnología de síntesis de voz (Text-To-Speech), estos sistemas todavía dejan algunas pistas, por ejemplo, en frases largas con pocos signos de puntuación, en interrogativas o exclamativas, donde suelen tener más dificultades para generarlas con la misma naturalidad humana. Este ingeniero explica que generar de manera sintética habla que pueda incluir inflexiones emocionales sigue siendo un reto importante en la comunidad.

“Dependiendo del contexto, los humanos no entonamos las preguntas de la misma manera, o en frases largas hacemos paradas para coger aire que a menudo los sistemas automáticos no resuelven con la misma naturalidad”, explica.

Aunque suele trabajar más con vídeos e imágenes generadas por IA, Pérez Blanco hizo una vez unas pruebas para recrear la voz de una persona desaparecida. Aunque la tecnología para cambiar el timbre de una voz a otra ya existe, descubrió que no es posible traducir una voz a otra de esa manera. La voz es mucho más que el timbre, y es mucho más que el acento: si cojo una voz y le pongo un acento argentino no va a sonar como Ricardo Darín. Hay un tono de voz personal, que llevaría mucho más lograr. “Incluso entre dos madrileños hay muchas diferencias. Todo el mundo crece y evoluciona hasta encontrar un tono que básicamente marca su personalidad: el tiempo que duran las vocales, la fuerza con la que pronuncias ciertas consonantes, como la D, ese tipo de cosas. La interpretación que tiene que hacer la máquina es muy distinta”, dice Pérez Blanco.

Cada vez existen más aplicaciones web que permiten verificar, con mayor o menor grado de precisión, si un contenido es real, ha sido manipulado o directamente es falso, aunque las más extendidas y conocidas están basadas principalmente en el análisis de imágenes y vídeos generados con IA. Entre las empresas que ofrecen soluciones para detectar si un contenido es falso o no encontramos: Sensity y RealityDefender, ambas de pago. Entre las accesibles y gratuitas están DeepfakeProof, de DuckduckGoose, que funciona como un plugin de Google Chrome, o Deepware. Intel, Google y Meta también están desarrollando e investigando sobre estas tecnologías para ofrecer soluciones para la detección de imágenes, vídeo y audio generado por IA.

- Sam Gregory, director ejecutivo de WITNESS

- Aitor Álvarez, responsable del Grupo de Tecnologías del Habla en Vicomtech

- Alejandro Pérez Blanco, creador de deepfakes de vídeo, El Intermedio

- Ramon Arteman, director de Metropolitana

- El arresto de Trump, el abrigo del papa o Putin arrodillado: bulos de imágenes creadas con inteligencia artificial

- Wired, The World Needs Deepfake Experts to Stem This Chaos

- How To Spot A Deepfake Like The Barack Obama–Jordan Peele Video

- Supuesto deepfake de Phyo Min Thein

- Fake images of Trump arrest show ‘giant step’ for AI’s disruptive power

- Los creadores del deepfake de Lola Flores: “Ya no se puede confiar en que todo lo que se ve en un vídeo es real”

- Deepfakes, mentiras y vídeo

QUISIERA SABER SI UNA GRABACION DE VOZ QUEDA CONSTANCIA DE LA FECHA Y HORA

DE LA GRABACION.

UNA GRABACION POR I.A. QUEDA CONSTANCIA DE LA FECHA Y HORA