El éxito de crítica y público de ChatGPT ha hecho que en los últimos meses millones de personas den todo tipo de usos a estos chatbots de IA generativas, incluido el de soporte emocional. Esto ha disparado una nueva serie de preguntas sobre la protección de los datos personales y la información que damos a estas plataformas a través de sus chatbots.

Hace unas semanas, ChatGPT agregó algunas opciones de privacidad tras recibir una advertencia de la autoridad italiana. Pero con una Ley de IA europea a la que aún le faltan unos dos años para entrar en vigor, el popular chatbot sigue siendo investigado por el Comité Europeo de Protección de Datos (CEPD).

La naturaleza conversacional de este tipo de chatbots con IA, que en algunos casos hasta tienen nombres humanos como Claude o LuzIA, predispone a los usuarios a tener más confianza y dar más información que la que meten en un buscador, por ejemplo. Consultas que en muchos casos contienen datos privados o sensibles, como los de salud, o que pueden revelar nuestro estado mental o emocional, son parte del contenido que estas nuevas plataformas recogen sin que los términos en los que tratan estos datos estén claros.

Empresas como Apple, Telefónica, Red Eléctrica o BBVA ya han prohibido o limitado su uso a sus empleados en dispositivos móviles de la empresa o con información de la compañía por temor a filtraciones.

La Agencia Española de Protección de Datos (AEPD), que tiene una investigación abierta sobre OpenAI por ChatGPT, por el momento no ha recibido reclamaciones sobre otros chatbots que utilizan IA generativa. Consultada por Newtral.es, hace una serie de recomendaciones generales para todo el que se dispone a usar alguna de estas herramientas.

De acuerdo a ellas, y con la ayuda de expertos en protección de datos, hemos analizado uno a uno varios chatbots basados en grandes modelos de lenguaje para entender cómo tratan nuestros datos y qué adecuación al Reglamento General de Protección de Datos tienen.

Son cuatro: ChatGPT, el gran éxito de OpenAI cuyo lanzamiento en abierto aceleró la carrera en IA; Bing chat, la inclusión de la IA generativa en el buscador de Microsoft; Claude, de Anthropic, competidor de ChatGPT creado por exempleados de OpenAI; y LuzIA, un chatbot español popular que se utiliza vía WhatsApp, cuyas cuestiones relacionadas con protección de datos hemos analizado en profundidad en Newtral.es.

Bard, el bot conversacional desarrollado por Google como respuesta directa al auge de ChatGPT, no está disponible en la UE, y aunque Google no ha explicado oficialmente por qué, ha dicho que ampliará su disponibilidad de acuerdo a las normativas locales y sus principios de IA, por lo que se supone que la protección de datos en lo relacionado con este chatbot puede ser una de las razones.

ChatGPT (OpenAI) y la protección de datos

En Newtral.es hemos publicado un reportaje específico sobre ChatGPT y la privacidad, donde explicamos los distintos frentes en torno a la protección de datos personales que tenemos que observar cuando hablamos con el popular chatbot: los datos que se dan para registro de usuarios; los prompts o instrucciones, que son nuestra conversación con el chatbot, y los textos que genera.

Los ajustes por defecto de ChatGPT están configurados para que las conversaciones de los usuarios sirvan para entrenar los modelos de la compañía de IA. Lo supimos después de la advertencia de la autoridad italiana de protección de datos a la empresa dueña del chatbot, cuando OpenAI incluyó la posibilidad de excluir del entrenamiento las sesiones de los usuarios que lo prefieren.

OpenAI tiene una política de privacidad, algo que requiere la AEPD, pero como explica Gonzalo Oliver Martin, abogado y socio de la Asociación Española de Delegados de Protección de Datos, es una política global y no conforme a la Unión Europea, que no termina de cumplir la normativa. Lo mismo pasa con la protección de datos del resto de chatbots analizados en este artículo.

En su política de privacidad, OpenAI se refiere únicamente a los datos de registro, que son los que el usuario da para crear su cuenta. Ni en ese texto legal ni en otros que se encuentran en la web de OpenAI aclaran cómo tratan los datos personales de las fuentes que usan para generar contenido (todos los textos de entrenamiento) y cómo los protegen, como también verificó Paula Ortiz, abogada experta en derecho digital. En este sentido no podemos ejercer los derechos de protección de datos como rectificación o cancelación en el chatbot. Sabemos que los grandes modelos de lenguaje como ChatGPT tienen “alucinaciones” o errores factuales. Si ChatGPT genera información falsa que afecta a una persona, no provee una opción para que el afectado pueda acceder a cambiar la información errónea sobre sí mismo.

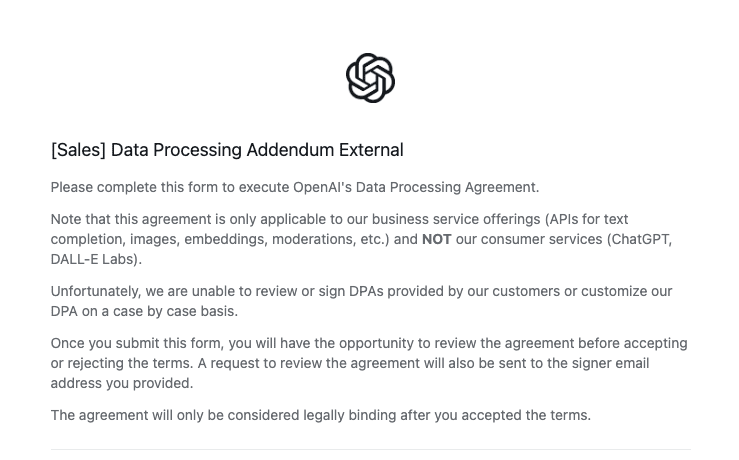

Comprobamos también que el tratamiento de los datos del contenido que procesan en nombre de sus clientes es diferente para usuarios de pago que para los que hacen uso gratuito del servicio. Para los primeros, que utilizan la API de clientes, la empresa dice que se rige por acuerdos que son privados (no los conocemos). Para los segundos no se encuentra información en la web.

La única vez en la que se menciona al Reglamento General de Protección de Datos de la UE en los términos de uso del chatbot, se hace para referirse al acuerdo (Data Processing Addendum External) que deben firmar las compañías que quieran utilizar la API de OpenAI para procesar datos para ofrecer otros servicios, y no para los usuarios de sus servicios, como ChatGPT o Dall-E.

En abril de este año, OpenAI introdujo en su política de privacidad un enlace con referencia al tratamiento de los datos contenidos en su material de entrenamiento. Allí explican cómo funcionan los grandes modelos de lenguaje a nivel general, dicen que su “información de entrenamiento incluye incidentalmente información personal”, y que no la utilizarán para crear perfiles de usuarios, contactarlos o intentar venderles algo.

ChatGPT ha sido desarrollado utilizando información públicamente disponible en internet, información que ha sido obtenida por OpenAI a través de terceros, e información provista por usuarios o marcadores humanos. El artículo sobre el tratamiento de datos sólo se refiere al primer grupo. Desde Newtral.es nos hemos puesto en contacto con OpenAI, pero hasta el momento de la publicación de este reportaje no hemos recibido una respuesta.

La protección de datos en Bing chat (Microsoft)

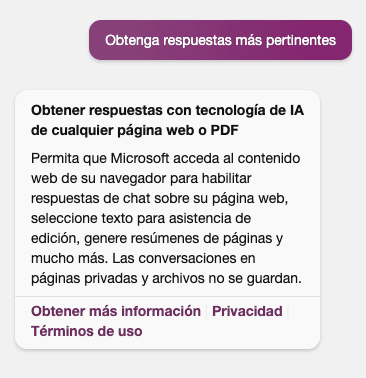

La política de privacidad de Bing, el chatbot de Microsoft, es la misma que la de Microsoft Edge, ya que se trata de una función integrada en el navegador. Tras su inversión en OpenAI, Microsoft agregó esa función de chat a su buscador Bing, que funciona de la misma manera que ChatGPT, aunque además tiene conexión a internet. Cuando uno selecciona respuestas “más pertinentes” en Bing chat, la ventana de diálogo pide permiso para que Microsoft acceda al contenido web del navegador. Con esto, ya sabe qué páginas visitamos y nuestro historial de búsquedas. La excusa es que así el chatbot pueda responder sobre esas webs, gestionar los textos que aparecen allí para asistir en la edición, hacer resúmenes “y mucho más”.

Microsoft aclara que las conversaciones en páginas privadas y archivos no se guardan, pero sí conservan datos personales con distintos períodos de tiempo de retención. Lo hacen “durante el tiempo que sea necesario” además de para cumplir con el servicio, “para otros fines legítimos, como el cumplimiento de nuestras obligaciones legales, la resolución de disputas y el cumplimiento de nuestros contratos”.

En el extenso texto de política de privacidad y protección de datos que abarca a todos los productos de Microsoft se hace referencia a la IA integrada en sus chatbots, además de Bing. Los servicios de este buscador, que se encuentra integrado en otras apps de Microsoft, como Microsoft 365, Cortana, y determinadas funciones de Windows, recopilan y tratan datos “de muchas formas, incluido el texto que se haya escrito a mano o en el teclado, e imágenes”, especifican. Al hacer una búsqueda o utilizar el chatbot, Microsoft recopila estos prompts, que pueden tener forma de texto, datos de voz o imagen, junto con otros datos: la dirección IP, ubicación, identificadores únicos de las cookies, hora y fecha y la configuración del explorador.

Para Oliver Martín, lo más grave en materia de protección de datos, es que al igual que el resto de chatbots utilizados, todas envían datos a Estados Unidos, una jurisdicción considerada no segura por la UE. Los dos acuerdos para transferencias internacionales de datos que aprobó este país han sido tumbados por el Tribunal de Justicia de la Unión Europea (Privacy Shield, invalidado en 2020, y el Safe Harbor, invalidado en 2015). Un nuevo acuerdo que está a punto de aprobarse en EE.UU. ha sido rechazado por el Parlamento Europeo el pasado mayo por ser negativo para los ciudadanos europeos. Hasta el momento de la publicación de estas líneas, Microsoft no ha respondido al pedido de Newtral.es de comentarios sobre este tema.

Claude (Anthropic) y la protección de datos

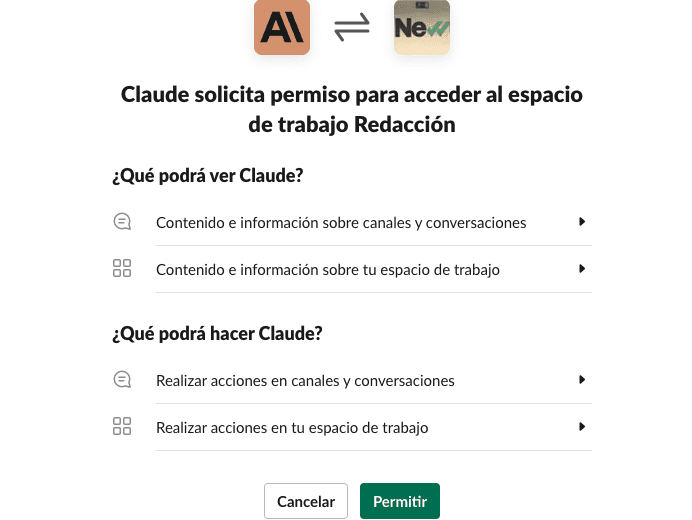

Anthropic es una startup formada por un grupo de exempleados de OpenAI que dejaron la compañía por desacuerdos con la dirección comercial. Bajo la premisa de una IA más “manejable” y menos tóxica, han desarrollado un gran modelo de lenguaje similar a ChatGPT llamado Claude, que está disponible solicitando acceso a través de su web, vía API y en Slack. Según Anthropic, Claude también está integrada en varios productos como DuckAssist en DuckDuckGo, Notion AI y un chat en Quora llamado Poe.

Claude, al igual que ChatGPT y Bing chat, tiene política de privacidad pero no aviso legal. Los juristas consultados por Newtral.es observan que la política de privacidad de estas plataformas relacionadas con los chatbots de IA, aunque presente, no se adecua totalmente a la normativa europea de protección de datos: no hay suficiente transparencia en los términos relacionados con el tratamiento de los datos, piden más información de la necesaria sin especificar sus fines específicos, y piden un consentimiento demasiado general que no cumple lo que especifica el reglamento europeo.

Elena Davara, experta en protección de datos, señala que en estos chatbots de IA generativa existe la necesidad de indicar de qué manera se pueden ejercer esos derechos sobre los datos. "Es decir, solicito un derecho de supresión y ¿van a eliminar todo mi historial de chat? ¿Qué pasará con lo que la IA haya aprendido de mí, se elimina? ¿Solicito un derecho de acceso y me van a indicar a quién han cedido todo?", se pregunta, y explica que las respuestas son cuestiones que se convierten en obligaciones en protección de datos para estos chatbots y que se han de tener en cuenta a la hora de llevar a cabo cualquier tratamiento de datos personales, y “si la IA utiliza datos personales también “trata” datos personales”, agrega. También dice que debería explicarse el procedimiento en caso de brecha de seguridad, y si se ha valorado la necesidad de llevar a cabo la evaluación de impacto en protección de datos.

Al usar Claude desde Slack, advierten que el chatbot leerá todas las conversaciones en las que esté mencionada, y que Anthropic no utiliza esta información para entrenamiento de sus modelos. Advierten también que pueden coger contenidos de las páginas web que se comparten en las conversaciones en Slack. “Piensa en Claude como en un miembro amable y trabajador de tu equipo: háblale con naturalidad y dale instrucciones muy concretas sobre lo que quieres que haga exactamente”, animan desde la web. Hemos pedido un comentario a Anthropic, la empresa dueña de este chatbot, sobre la adecuación de Claude al reglamento de protección de datos, pero hasta el momento no tenemos respuesta.

Checklist de privacidad para los chatbots de IA generativas

Según la AEPD

- Política de privacidad y/o aviso legal que incluyan:

- identificación clara y precisa del responsable del tratamiento, y de sus datos de localización, fiscales y contacto

- información clara de protección de datos con referencia al RGPD

- información para poder ejercer los derechos de protección de datos

- información sobre si el chatbot continúa aprendiendo de las conversaciones mantenidas con los usuarios y qué operaciones realiza con esos datos una vez mejorado

Se recomienda, además de lo anterior, no aceptar que se soliciten datos de registro que no sean necesarios; que se solicite consentimiento sin definir para qué se van a tratar los datos y sin que permitan retirarlo en cualquier momento, o que realicen transferencias a países que no ofrezcan garantías suficientes.

La Agencia también recomienda limitar los datos personales que se exponen, no dar datos personales de terceros si hay dudas de que el tratamiento va a trascender el ámbito doméstico y tener en cuenta que no hay garantías de que la información proporcionada por el chatbot sea correcta. Dependiendo del sistema, puede producir daño emocional, desinformación o inducir a engaño.

- Agencia Española de Protección de Datos

- Gonzalo Oliver Martin, consultor jurídico sobre privacidad, protección de datos y ciberseguridad en KPMG. Socio de la Asociación Española de Delegados de Protección de Datos

- Elena Davara, experta en GDPR, abogada de Davara&Davara Asesores Jurídicos

- OpenAI, Terms & policies

- OpenAI, How ChatGPT and Our Language Models Are Developed

- Declaración de privacidad de Microsoft

- Anthropic, Privacy Policy

- Anthropic, an A.I. Start-Up, Is Said to Be Close to Adding $300 Million

- Anthropic introduces Claude, a “more steerable” AI competitor to ChatGPT, Ars Technica

- Exempleados de OpenAI lanzan Claude, un chatbot similar a ChatGPT "más manejable" y con resultados menos dañinos

- Cuando charlas con ChatGPT, OpenAI utiliza tus conversaciones para entrenar a su IA. Ya puedes evitarlo

- I know this will sound lame, but does anybody else use ChatGPT for emotional support?

- ¿Puede un chatbot guardar un secreto? La privacidad de nuestras conversaciones con una IA como LuzIA

- Las lagunas en torno a ChatGPT y la privacidad: vacío legal o pesadilla de protección de datos

- Foto de Fiona Art