A inicios de noviembre, la cadena de noticias Fox News publicó en su web varios vídeos en los que supuestos beneficiarios de un programa de ayuda alimentaria amenazaban con “saquear” supermercados, en pleno cierre del Gobierno de Estados Unidos.

Las imágenes acumularon millones de reproducciones en redes sociales. Pero había un problema. Las personas que aparecían no eran reales, sino personajes generados con inteligencia artificial. Cuando el medio de comunicación se percató del engaño, retiró el contenido.

El caso de Fox News no fue aislado. En 2025, la expansión de herramientas de generación de vídeo con IA, como Sora (el modelo de inteligencia artificial de Open AI), ha facilitado la creación de escenas hiperrealistas que imitan situaciones de conflicto, emergencia o tensión social. Estos contenidos sintéticos circulan en redes con una apariencia de autenticidad que dificulta su detección y acelera su difusión, según expertos consultados por Newtral.es, creando confusión entre la ciudadanía. Ha ocurrido en México, Jamaica, Brasil y también en España.

Sam Gregory, director ejecutivo de WITNESS, una organización internacional sin ánimo de lucro que ayuda a las personas a utilizar vídeos y tecnología para proteger y defender los derechos humanos, habla de un problema “pronunciado” a nivel mundial, ya que el contenido generado con IA “es cada vez más difícil de detectar”. “En 2025, los deepfakes generados por IA se volvieron mucho más realistas con nuevos modelos de vídeo como Sora 2 y Veo 3”, dice a Newtral.es.

- En apenas dos años, el contenido generado con inteligencia artificial ha avanzado tanto que, según algunos análisis, ha transformado el ecosistema de la desinformación.

Loreto Corredoira y Alfonso, codirectora del Observatorio Complutense de la Desinformación de la Universidad Complutense de Madrid, dice a Newtral.es que la IA ha acelerado la desinformación, “tanto en el fondo —por los nuevos desórdenes informativos que genera— como en la forma, por la falta de transparencia respecto al origen o la fuente del bulo, la noticia falseada o el vídeo ultrafalsificado”.

Herramientas como Midjourney popularizaron la creación de imágenes sintéticas de alta calidad, primero como ilustraciones y, más tarde, como material fácilmente confundible con fotografías reales. Ese cambio ya supuso un desafío para la verificación, pero el impacto se multiplicó con la llegada de modelos capaces de generar vídeos.

Crisis de confianza. Al respecto, Gregory advierte de que el principal riesgo de normalizar la creación y circulación de contenidos engañosos generados con inteligencia artificial, aunque sean hiperrealistas, es la erosión de la confianza. No solo en cada pieza concreta, sino en la propia capacidad de la ciudadanía para distinguir entre lo auténtico y lo sintético.

Las falsificaciones individuales y las campañas de desinformación son relevantes, señala, pero el peligro mayor es otro: “Que se instale un clima de duda permanente, en el que cualquier imagen o sonido pueda ponerse en cuestión”.

Esa desconfianza ya se ha manifestado incluso ante contenidos reales. Ocurrió, por ejemplo, cuando Estados Unidos atacó por primera vez una embarcación en el Caribe venezolano, en el marco de su ofensiva contra supuestos cárteles del narcotráfico. El vídeo difundido por las autoridades estadounidenses fue recibido con escepticismo y generó dudas sobre su autenticidad, una sospecha alimentada en parte por la narrativa del Gobierno venezolano, que afirmó que se trataba de contenido sintético. Tras analizar el material, los verificadores concluyeron que las imágenes eran reales.

La Unión Internacional de Telecomunicaciones de las Naciones Unidas (UIT) expresó este año que los deepfakes (imágenes y vídeos generados por IA) y los audios que se hacen pasar de manera convincente por personas reales plantean riesgos crecientes. “La confianza en las redes sociales ha disminuido significativamente porque la gente no sabe lo que es verdadero y lo que es falso”, señaló Bilel Jamoussi, jefe del Departamento de Grupos de Estudio de la Oficina de Normalización de la UIT.

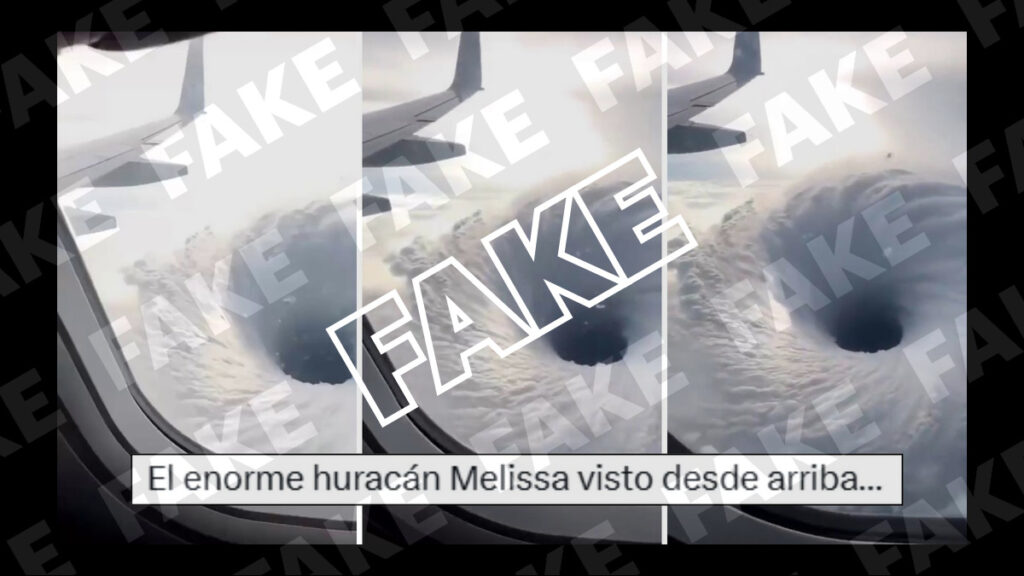

La desinformación generada con inteligencia artificial ha mostrado un impacto notable en contextos de crisis. Durante el paso del huracán Melissa por Jamaica, a finales de octubre, circularon en redes sociales vídeos hiperrealistas hechos con IA que mostraban inundaciones extremas y escenas de destrucción que no correspondían con la realidad, lo que obligó a autoridades y verificadores a desmentir contenidos falsos en plena emergencia.

Algo similar ocurrió durante los grandes incendios forestales en California, cuando imágenes y vídeos creados artificialmente se difundieron como si fueran grabaciones reales del avance del fuego. En España también se difundieron contenidos sintéticos relacionados con la dana de octubre de 2024 en Valencia, y en Estados Unidos se difundieron decenas de vídeos sobre supuestas redadas contra inmigrantes.

- Newtral.es ha verificado en 2025 un total de 140 bulos generados con inteligencia artificial.

“La IA facilita la generación de la representación perfecta de un problema: la víctima emblemática de una emergencia, el momento esencial de una crisis, como hemos visto en las inundaciones, protestas y conflictos que han tenido lugar en todo el mundo durante el último año”, explica Gregory, de WITNESS, quien menciona que las imágenes generadas con IA de víctimas de inundaciones y devastación moldean la percepción pública y los discursos políticos, independientemente de si los espectadores sabían que las imágenes eran sintéticas.

- “En estos contextos delicados, las consecuencias son concretas: el contenido falso puede desviar los recursos de emergencia, avivar las tensiones contra comunidades vulnerables o hacer que la gente desconfíe de las advertencias y los llamamientos de ayuda genuinos”, continúa.

- Los diplomáticos estadounidenses James P. Rubin y Darjan Vujica escribieron en la revista Foreign Affairs que la desinformación no es un problema nuevo, pero la introducción de la IA ha hecho que sea significativamente más fácil “para los actores maliciosos desarrollar operaciones de influencia cada vez más efectivas”.

Loreto Corredoira y Alfonso explica que un aspecto reseñable es que los riesgos son globales o universales, es decir, que viajan por todo el mundo, no solo porque las narrativas “se contagian”, como ocurre con tópicos sobre clima, vacunas o migración, sino porque, gracias a las herramientas automáticas de traducción o subtitulado, pueden replicarse en casi todos los países.

La experta plantea además que las consecuencias de estos contenidos afectan tanto a la toma de decisiones públicas como privadas, al basarse en datos erróneos o descontextualizados. El Observatorio Complutense de la Desinformación ha identificado efectos especialmente en el ámbito electoral: “No porque la desinformación modifique el sentido del voto —algo imposible de probar, dado que el voto es secreto y pensando además en la libertad de cada votante—, sino por la distorsión del debate político, muy sensible a estas narrativas, o por el ruido general que se genera”.

Algunos ejemplos de bulos con IA

A lo largo de 2025, en Newtral.es hemos verificado imágenes y vídeos generados con inteligencia artificial sobre incendios forestales en España y Estados Unidos; inundaciones en Jamaica con supuestos tiburones en piscinas tras el paso del huracán Melissa; clips de falsos telediarios con noticias inventadas; y vídeos relacionados con las guerras en Gaza y Ucrania. Estas son algunas de las verificaciones.

Niños atrapados por la tormenta Byron en Palestina. Circuló un vídeo de cinco niños atrapados con el agua hasta la cintura, acompañado de mensajes que afirmaban que se trataba de imágenes de las inundaciones en Palestina provocadas por la tormenta Byron. Sin embargo, el vídeo era falso y había sido generado con inteligencia artificial.

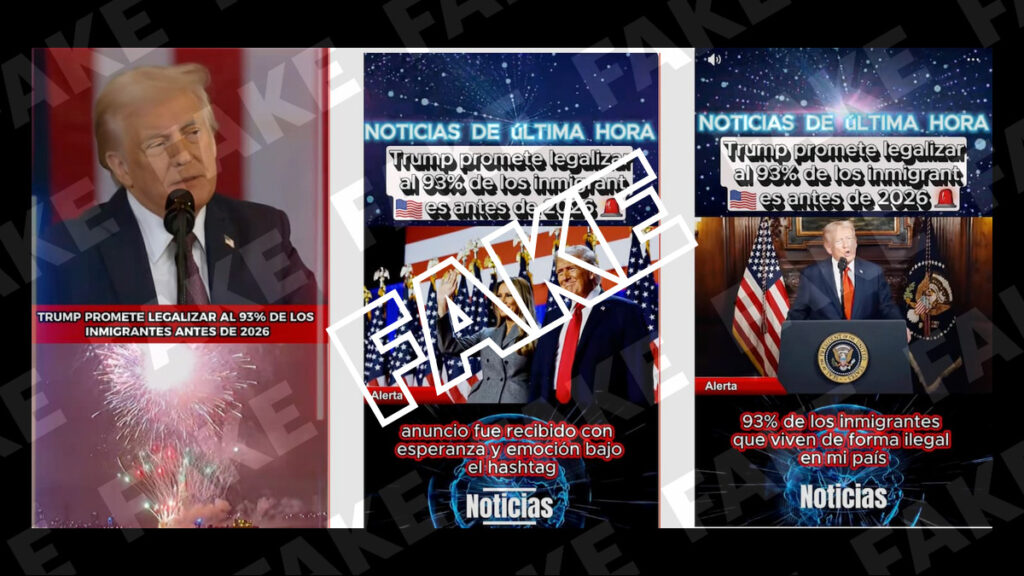

Trump prometiendo la legalización de los inmigrantes. En redes sociales se difundieron varios vídeos en los que aparece Donald Trump prometiendo legalizar a la mayoría de los inmigrantes que viven en Estados Unidos antes de 2026. Sin embargo, era falso: se trataba de imágenes generadas con inteligencia artificial y no había registros de que el presidente estadounidense hubiera anunciado una medida de ese tipo.

Irene Montero con “su sirvienta”. Se difundió una imagen de la eurodiputada Irene Montero junto a una mujer a la que los mensajes virales identifican como “su sirvienta filipina” que viste un uniforme con vestido negro, delantal blanco y cofia. Sin embargo, era falsa. Estaba generada con inteligencia artificial (IA).

Vídeo del ojo del huracán Melissa. En redes sociales se compartió un vídeo que supuestamente mostraba el huracán Melissa desde la ventana de un avión. Sin embargo, se trataba de un bulo: el vídeo estaba creado con inteligencia artificial. Una búsqueda inversa de fotogramas clave del clip viral en Google Lens conducía a un vídeo publicado en TikTok que incluía una etiqueta de contenido generado con IA.

Convoyes en la Moncloa. En redes sociales se difundieron dos vídeos que mostraban un supuesto convoy militar de Estados Unidos apuntando sus armas pesadas hacia el Palacio de la Moncloa. No había registros de que fuerzas del Ejército de Estados Unidos se hubieran posicionado frente al palacio con vehículos blindados. Además, los vídeos contenían la marca de agua de Sora.

Flotilla Global Sumud. Circuló por redes sociales una imagen en la que aparecen decenas de barcos surcando el mar con sus cabos repletos de banderas de Palestina junto con mensajes que afirman que se trataba de la flotilla Global Sumud. Aunque era cierto que las embarcaciones que conformaban este grupo de ayuda humanitaria portaban numerosos estandartes palestinos, esta imagen en concreto había sido generada con IA.

Pedro Sánchez y el servicio militar. Se difundió un vídeo en el que el presidente del Gobierno, Pedro Sánchez, supuestamente anunciaba que los jóvenes de entre 18 y 35 años deberían realizar el servicio militar obligatorio durante nueve meses. Era falso. El vídeo estaba manipulado y, en las imágenes originales, Sánchez no hacía ninguna mención al servicio militar obligatorio. Además, presenta indicios de que el audio que lo acompañaba había sido generado con inteligencia artificial.